--Approche scientifique de l'enquête sur les valeurs...

Introduction

La recherche sur le cerveau

Il est très difficile de déterminer quelles recherches doivent être menées dans le domaine de la science et de la technologie. La recherche elle-même est vraiment significative et mérite que l'on y consacre sa vie, car elle devrait être utile même dans un millier d'années.

Tant dans le domaine de la science, qui recherche la vérité, que dans celui de l'ingénierie, qui vise les applications technologiques pour la société, il sera important de clarifier la science et la technologie de plus en plus complexes en relation avec l'espace, la société et les êtres vivants. Il n'est pas difficile d'imaginer que cette considération suffise à elle seule à devenir une discipline majeure. Il y a par exemple la discipline de la philosophie des sciences.

Parmi les organismes vivants, la relation avec l'homme est un facteur particulièrement important de la valeur de la recherche. Si nous considérons le cerveau comme le centre de la pensée humaine, c'est lui qui sert de médiateur entre les personnes et la société. L'étude de l'homme, et plus particulièrement du cerveau, occupe une place importante dans le monde universitaire, d'autant plus qu'il est difficile d'élucider le cerveau.

1. Système de valeurs proposé par la science

Fig.1 Le chat de Schrödinger

La science a eu des implications majeures sur les systèmes de valeurs, comme le principe d'incertitude de la théorie quantique et la théorie de l'évolution basée sur les gènes. Le principe d'incertitude suggère que le monde n'est pas mécaniste et prédestiné, mais plein de possibilités imprévisibles.Selon le principe d'incertitude, il existe une indétermination dans le produit de l'énergie et du temps, de sorte que ces deux éléments ne peuvent être mesurés avec exactitude. Un exemple bien connu pour expliquer au grand public la relation entre le principe d'incertitude et les phénomènes macroscopiques est celui du "chat de Schrödinger". Si des processus quantiques déterminent si le chat dans la boîte est mort ou vivant, nous ne le saurons pas tant que nous n'aurons pas ouvert la boîte. Au niveau macroscopique, de telles choses sont impossibles [1], mais dans le domaine microscopique, elles se produisent fréquemment.

L'autre phénomène est ce que l'on appelle l'effet papillon dans la théorie du chaos[2]. Même un papillon battant des ailes peut avoir un effet sur la météo à long terme. L'effet papillon suggère également que le monde est imprévisible et incertain.

Penrose pense que les effets quantiques régissent les racines du fonctionnement du cerveau [3]. Cela implique-t-il également des phénomènes psychologiques imprévisibles ? Je pense qu'en principe, cela peut être expliqué par la logique classique. La raison en est que même dans les spins nucléaires, une mémoire qui se prête facilement au calcul quantique, cela ne fonctionne pas théoriquement assez bien pour constituer une logique [4]. Pour effectuer un calcul quantique, chaque spin doit être très indépendant et ne pas être soumis à des perturbations externes. Dans les liquides, les spins nucléaires sont très indépendants et des calculs quantiques peuvent être effectués à partir d'eux [1, 5], mais dans les solides, c'est difficile. Dans le cerveau, où l'interaction se fait dans le solide, un effet appelé décohérence, qui rompt l'indépendance des spins nucléaires, s'est avéré important [6]. Il serait difficile de construire des circuits logiques denses pour l'informatique quantique dans le cerveau.

Fig.2 Gènes et évolution

L'un des fondements du système de valeurs scientifiques a été fourni par une série d'études qui ont conduit à la théorie de l'évolution de Darwin (conservation des espèces)[7], à la découverte des chromosomes par Nagely, aux lois de l'hérédité de Mendel et à la découverte de la double hélice des gènes par Watson et Crick[8]. Elle suggère que le potentiel humain est lié aux gènes.L'une des conséquences du concept de gènes sur la pensée sociale est la théorie du gène égoïste, selon laquelle les gènes manipulent les humains [9].

2. La valeur de l'exploration du cerveau (l'importance du cerveau en tant que vecteur de valeur)

Fig. 3 Ordinateur et sa mémoire

Le nihilisme de Friedrich Nietzsche et le bouddhisme partagent une idéologie commune en ce sens qu'ils prennent tous deux du recul par rapport aux systèmes de valeurs absolus. Nietzsche nie que "ce qui est absolument juste" et "ce qui est absolument beau" [10]. Le bouddhisme, quant à lui, possède une grande quantité de contemplation qui se poursuit longtemps après son fondateur, le Bouddha. Une partie de cette contemplation est résumée dans le Sutra du cœur[11,12,13]. Le Soutra du cœur relativise toutes les idées et valeurs humaines arbitraires comme s'il observait la terre depuis un univers lointain.Si toute valeur est relative, comme le suggèrent le nihilisme et le Soutra du cœur, alors le cerveau a le statut de source de création de valeur au-delà de son existence en tant que récipient. L'élucidation de la fonction du cerveau est en soi une recherche de la source des critères de valeur. Bien que nous puissions décrire la relation entre le fonctionnement du cerveau et le comportement humain en termes de colère, de joie, de chagrin et de plaisir, il est difficile de montrer ce que sont la colère, la joie, le chagrin et le plaisir au niveau cellulaire. Afin d'élucider les fonctions cérébrales en détail, nous avons besoin d'une technologie permettant de mesurer la forme des cellules et leurs changements, et cette technologie progresse rapidement.

2.2 Cerveau et système de valeurs

Alors que la théorie quantique et la théorie génétique sont des explications des principes par lesquels les valeurs sont formées, le cerveau influence directement le comportement basé sur les valeurs. On peut dire qu'il traite les informations provenant de l'extérieur et qu'il régit les principes comportementaux qui font bouger les différentes parties du corps. Il s'agit des cinq sens que sont la sensibilité, l'appétit et la libido. Ils correspondent au firmware et aux fichiers système nécessaires au démarrage d'un ordinateur, ainsi qu'au système d'exploitation (OS) qui sert d'intermédiaire entre les programmes et le matériel. D'autre part, la mémoire est un facteur important qui façonne la personnalité d'une personne. C'est sur la base de la mémoire que s'exercent les principes comportementaux. La mémoire peut être divisée en mémoire temporaire et mémoire à long terme, ce qui peut s'appliquer à la mémoire dynamique à accès aléatoire (DRAM), un type de mémoire qui est un dispositif de stockage temporaire, et aux disques durs et supports de stockage optiques, qui sont des mémoires adaptées au stockage de données à long terme, respectivement. La DRAM est un type de mémoire qui convient au stockage temporaire, tandis que les disques durs et les supports de stockage optiques conviennent au stockage de données à long terme.Les ordinateurs sont constitués de différentes puces électroniques, dont les DRAM. Les puces IC sont les circuits intégrés à l'intérieur des ordinateurs. En 2022, les puces électroniques contiendront des dizaines de milliards de transistors, l'unité de base [14].

Ce sont les logiciels qui déterminent le fonctionnement d'un ordinateur. Sans logiciel, il ne fonctionnerait pas. Si nous savons quel type de logiciel se trouve dans un ordinateur, nous pouvons savoir à quoi il sert et comment il fonctionne. Les logiciels sont complexes, mais le principe de base consiste en un logiciel qui donne des commandes pour l'addition et la soustraction, et le matériel correspondant. Il est peu probable que le cerveau ait des mouvements aussi simples, mais on peut s'attendre à ce que la recherche commence par la connaissance de cette correspondance.

3. La clé du décryptage du cerveau

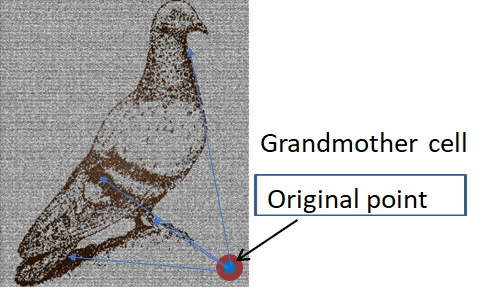

Si l'on considère que le cerveau a un impact significatif sur la valeur, on comprend que la recherche sur le cerveau est un sujet de recherche important, susceptible de relier les sciences humaines et la science. Pourtant, malgré le grand nombre de recherches sur le fonctionnement du cerveau, nous savons très peu de choses sur ce qui est important. Dans un ordinateur, l'unité de stockage est la cellule de mémoire (élément de stockage) composée de transistors, et les informations sont stockées sous forme de chiffres binaires de 01. C'est l'unité la plus élémentaire qui compose un ordinateur. En revanche, on ne sait pas comment l'information correspondant à 01 est stockée dans le cerveau. Par conséquent, on ne sait que très vaguement comment l'information stockée est traitée [15, 16].Le phénomène cérébral le plus évident lié à la mémoire est la cellule grand-mère. Lorsqu'un singe voit le visage de sa grand-mère, une cellule spécifique réagit fortement. C'est comme si une cellule correspondait à un souvenir [17]. Le nombre de neurones qui composent le cerveau humain est compris entre 50 et 100 milliards [18, 19], dont 10 milliards appartiennent au cortex cérébral [20, 21]. Pour un superordinateur de haut niveau, le nombre de transistors par puce est de 10 puissance 9 [22, 23], et le nombre de puces par ordinateur est de 10 puissance 5 [23]. Le nombre de transistors est donc de 100 000 milliards (14 puissances de 10). C'est un ordre de grandeur supérieur au nombre de neurones. Cependant, il n'est pas capable de faire autant de choses différentes qu'un être humain, et il ne semble pas supérieur au cerveau. L'idée qu'une cellule correspond à une mémoire n'explique pas cet avantage. Une possibilité est qu'il existe un réseau plus complexe de cellule à cellule. Par exemple, si la distance entre les cellules ou la forme des cellules est une source d'information, la quantité d'information augmenterait.

Dans le modèle de la cellule grand-mère, et s'il existe une transformation de type transformée de Fourier de l'espacement entre les neurones en un hologramme, alors non seulement le signal fort mais aussi le signal faible qui l'accompagne sont importants. Par conséquent, la méthode de mesure permettant de lire ce signal faible est importante. Le signal d'impulsion du neurone et la forme du neurone peuvent être des paramètres, et le signal peut être modifié par la forme du neurone. Il convient de se demander si la clé de l'information est l'intensité ou l'espacement du signal, et comment le signal se ramifie.

4. Modèle de la mémoire et de la pensée cérébrales

En ce qui concerne la phénoménologie du cerveau, il existe un grand nombre de recherches sur les voies de transmission de l'information neuronale et sur la localisation des lieux de mémoire. Cependant, le mécanisme de la mémoire n'est pas compris. La question de savoir s'il s'agit d'un mécanisme quantique, un phénomène indéterminé, ou d'un mécanisme classique, comme une horloge mécanique, est toujours débattue [3].Les modèles varient également, et les perspectives mises en avant par chacun d'entre eux sont différentes. La théorie de Gabor selon laquelle la mémoire associative peut être expliquée par la mémoire holographique [24] se concentre sur le cerveau humain, qui est doué pour les associations. Une autre théorie veut que l'esprit soit influencé non seulement par le cerveau, mais aussi par les organes internes [25]. En outre, certaines théories affirment qu'il existe des puces cérébelleuses et cérébrales en tant que structures fonctionnelles qui contrôlent l'activation d'autres réseaux que les réseaux neuronaux, et qu'elles sont à l'origine de la mémoire [26, 27]. Une autre direction consiste à essayer d'expliquer le fonctionnement du cerveau en utilisant un modèle électrique de calcul. Il s'agit par exemple d'une tentative d'expliquer le processus d'apprentissage et de clarifier le mécanisme par lequel les humains émettent des jugements grâce à l'échange de signaux dans différentes parties du cerveau [28, 29].

5. Traces de mémoire : Engrammes

Le cerveau est grossièrement divisé en deux parties : le cerveau et le cervelet. Parmi les organes cérébraux, l'hippocampe, situé sous le cerveau, serait impliqué dans la mémoire. À proximité se trouve le thalamus, qui sert de voie de transmission des informations visuelles au cerveau. Les informations relatives à la forme sont transformées par Fourier et classées en triangles, carrés, etc. [30, 31, 32]. Ainsi, de nombreuses études ont été menées sur les voies et les emplacements généraux de stockage des informations de la mémoire [33].D'autre part, nous ne savons pas où et comment les souvenirs d'images sont stockés et comment ils sont rappelés [34]. Ce qu'il faut, c'est trouver un cadre théorique complet, un ensemble de lois de transition qui expliquent comment les événements mentaux sont liés aux schémas d'activité cérébrale de manière redondante [35]. Il n'est pas non plus évident de savoir où sont laissées les traces de mémoire (engrammes) qui constituent la base de cette étude. Par exemple, une cellule unique réagit fortement à des informations d'image spécifiques, telles que le visage d'une grand-mère. Cependant, on ne sait pas comment l'information est représentée et sous quelle forme elle est stockée au niveau cellulaire. Et la question est de savoir ce qu'il faut révéler pour fournir cet indice. Cela nous amène à la vraie question : que mesurer ?

Malgré les nombreuses recherches effectuées, l'impossibilité de localiser les traces de la mémoire suggère la nécessité d'intégrer de nouvelles méthodes de recherche.

6. Importance de la mesure du cerveau

Nous avons évoqué la possibilité que le cerveau, qui n'est qu'un vaisseau, contribue à la création de valeur, mais l'élucidation du cerveau n'a pas encore atteint le point où il peut être lié à la valeur. La compréhension du cerveau nécessite diverses connaissances. Le processus de croissance du cerveau, les mécanismes de la mémoire et de la transduction des signaux, et les modèles du cerveau basés sur ces mécanismes en sont quelques exemples. La présence ou l'absence de connexions avec d'autres organes est également importante. Les principes du comportement humain ont été étudiés en psychologie, mais en fin de compte, une compréhension intégrée du cerveau jusqu'à ses fonctions microscopiques permettra des discussions qui le relient à la valeur[36].Ce qui importe, c'est la manière dont le sens et la valeur sont liés à la mémoire et au traitement des signaux dans le transfert d'informations neuronales. La question est de savoir comment les concepts abstraits de sens et de valeur sont représentés au niveau du signal. Par exemple, l'émergence de différentes réponses dans un processus répétitif constant peut indiquer une certaine signification. Il peut aussi être important que la réponse change en fonction de modèles d'entrée spécifiques.

Prenons le cas où les signaux externes envoyés aux cinq sens sont toujours les mêmes. Par exemple, si une personne est confinée dans une pièce sans fenêtre ni objet, mais uniquement avec des murs, et que ses yeux sont fermés, elle peut penser et créer. Un adulte qui a déjà formé de nombreux souvenirs peut penser et créer quelque chose même sans signaux de l'extérieur. Si le sens et la valeur ne peuvent être créés qu'à l'intérieur du cerveau, le contenu du signal de sortie changerait spontanément, même si les signaux externes sont stables.

La même entrée, dans une série temporelle, devrait montrer des réponses différentes. Cela peut être dû à la reconnexion ou à la modification des neurones, ou à la reproductibilité du signal. La manière dont les souvenirs sont stockés et les valeurs formées sera une clé importante pour relier le cerveau et la société.

La psychologie a étudié de nombreux principes du comportement humain. Nous avons examiné les caractéristiques de la boîte noire qu'est le cerveau sur la base de diverses études de cas. À l'avenir, nous parviendrons à une meilleure compréhension en établissant une correspondance entre les événements psychologiques et des preuves plus physiques basées sur le cerveau. Par exemple, des expériences utilisant des souris génétiquement modifiées avec des cerveaux altérés ont révélé la relation entre la fonction cérébrale et des gènes spécifiques [37]. En outre, l'établissement d'un lien entre la valeur et le cerveau révélerait comment certains souvenirs sont considérés comme désirables et liés au comportement.

La technologie de mesure a progressé rapidement et de nombreux modèles de cerveau ont été proposés, mais ils n'ont pas encore atteint un niveau qui contribue à l'élucidation du cerveau. Par exemple, la vitesse et la résolution des mesures sont considérées comme insuffisantes. Le modèle du cerveau fait encore l'objet de débats sur le principe de son caractère quantique ou non.

Des structures microscopiques ont été mesurées pour des régions du cerveau, telles que le cerveau, le cervelet, le lobe frontal, le lobe temporal et d'autres segments, et le rôle général de chaque région devient plus clair. Les mesures utilisant des électrodes comme terminaux de mesure et la fluorescence comme marqueur pour des zones spécifiques ont révélé les fonctions des neurones, l'unité de base du cerveau, au niveau moléculaire.

De nombreux efforts ont donc été consacrés à l'étude du cerveau. Cependant, parmi les différents aspects de la connaissance, les mécanismes du cerveau semblent être les moins bien compris. La mémoire optique Blu-ray stocke un seul bit en tant qu'unité. En chaque point, un 1 ou un 0 est déterminé par la réflectance élevée ou faible. Nous ne savons même pas quelles sont les traces de mémoire correspondantes dans le cerveau. En d'autres termes, le principe de la mémoire n'est pas clairement compris. Par exemple, lorsque nous mémorisons le visage de notre grand-mère, un ordinateur le décompose en 1 et 0 et les stocke dans des circuits intégrés, mais on ne sait pas quel type d'information est stocké dans le cerveau. L'imagerie par résonance magnétique (IRM) a fourni une grande quantité d'informations. En outre, il est nécessaire d'améliorer les techniques de mesure dans de nombreux domaines, tels que la résolution spatiale et temporelle et la sensibilité, la profondeur de pénétration, la différenciation des éléments et la détection des changements dans la structure moléculaire. Nous nous concentrons en particulier sur les neurones, l'unité de base du cerveau. Les points d'intérêt sont les ramifications des signaux vers les neurones voisins et la modulation de l'intensité de chaque signal dans un court laps de temps. Si cela peut être mesuré à grande vitesse, avec une grande sensibilité, une grande précision, de manière non destructive et sans contact, il est très probable que de nouvelles informations puissent être obtenues.

Fig.4 Image d'un neurone à cellules grand-mère et d'un pigeon [16]

Fig.4 Image d'un neurone à cellules grand-mère et d'un pigeon [16]Les traces de mémoire seraient de légers changements dans la forme des neurones [38]. Mais une seule cellule peut-elle mémoriser des visages aussi complexes ?

Il existe un concept appelé hologramme. Dans la mémoire holographique, l'information est enregistrée sur une surface, et en changeant l'angle d'incidence, par exemple, plusieurs éléments d'information peuvent être lus. Dans la lumière, l'interférence est basée sur le fait que le front d'onde est maintenu. Si les signaux cérébraux sont maintenus dans la gaine de myéline, avec leur cohérence, il n'est pas surprenant que des effets d'interférence similaires se produisent. La vision, où l'information d'entrée est claire, serait la plus facile à analyser. La voie visuelle a été bien étudiée, mais son lien avec la mémoire n'est pas clair [39].

L'hologramme est délocalisé avec une zone de mémoire élargie, mais il existe également un modèle de mémoire localisée. Lorsqu'un front d'onde est diffusé par une image et un point de diffusion important qui sert de référence, l'image originale peut être récupérée par transformation de Fourier du modèle de diffusion.

Dans cette mesure de la diffusion de la lumière, le contraste du modèle de diffusion est le plus élevé lorsque le point focal se trouve juste devant le diffuseur. S'il y a deux diffuseurs, le diagramme est déterminé par la distance entre les deux diffuseurs. En utilisant la distance entre les diffuseurs comme information, un modèle de mémoire peut être construit. Si ce modèle peut être appliqué à la mémoire neuronale, nous pouvons considérer la cellule grand-mère comme le pilier central ayant l'intensité de diffusion la plus élevée parmi les multiples diffuseurs, et le contraste sera le plus élevé lorsqu'une vague de signaux électriques en phase avec la cellule grand-mère arrivera dans la région contenant la cellule grand-mère et la cellule correspondant à son information.

Cela signifie que l'information est formée à partir de la distance entre cette cellule et les autres cellules, à partir de cette cellule. Si c'est le cas, on n'observe que des signaux forts, et la véritable information serait contenue dans les signaux faibles qui se dirigent vers d'autres cellules.

La nécessité de mesurer les signaux faibles peut être déduite des cellules grand-mère. Si des signaux faibles affectent la mémoire, il est nécessaire de mesurer le signal de chaque neurone avec une grande sensibilité. Comme les signaux sont des séries de pointes qui s'alignent à des intervalles de l'ordre de la ms, il est important d'obtenir à la fois une vitesse et une résolution élevées. Les caméras récentes à haute sensibilité ont atteint des vitesses de mesure de près de 1 μs par image avec une sensibilité et une gamme dynamique élevées[40].

Note : Par exemple, la caméra à grande vitesse FASTCAM Mini AX de Photron est une caméra à grande vitesse avec une vitesse de prise de vue de 20 000 images par seconde à 640 x 480 pixels. En plus de la haute résolution des images monochromes 12 bits, la caméra a atteint une sensibilité ultra-élevée de 40 000 ISO monochrome.

Le cerveau est un réseau de neurones disposés en forme de treillis. La plupart des études précédentes se sont limitées à la transmission monosynaptique dans le meilleur des cas [41]. En réalité, même la transmission monosynaptique n'a pas été analysée avec précision. La méthode la plus courante pour analyser la transmission monosynaptique consiste à insérer une électrode dans un neurone et à mesurer le changement de potentiel. Cependant, dans cette méthode, l'électrode peut affecter le signal. La mesure optique est une méthode prometteuse pour la mesure sans contact. Une méthode de mesure 3D à grande vitesse et à haute résolution par holographie ou par absorption à deux photons est à l'étude[42].

Outre l'holographie et l'absorption à deux photons, il existe d'autres méthodes de mesure optique des signaux provenant de plusieurs neurones qui utilisent la diffusométrie [43].

Les hologrammes sont supérieurs en ce sens qu'ils permettent de contrôler facilement la collecte spatiale de la lumière et la position de détection. L'absorption à deux photons est unique en ce sens qu'elle permet d'effectuer des mesures en profondeur dans le cerveau. En revanche, la diffusométrie est supérieure en termes de résolution et de vitesse de mesure.

La méthode de mesure des signaux dans le cerveau dépend de l'objet à mesurer. Le cerveau peut être divisé en trois catégories : la surface supérieure, quelques millimètres de profondeur et le cerveau entier. En outre, la résolution et la vitesse de mesure sont des facteurs importants. Les méthodes de mesure peuvent être classées comme étant sans contact, avec contact ou destructives.

Les techniques permettant de mesurer l'ensemble du cerveau sont le scanner à rayons X et l'IRM. Ces techniques permettent de mesurer la structure de l'ensemble du cerveau de manière non invasive. L'IRM, en particulier, peut capturer non seulement la structure mais aussi la motilité moléculaire. Sa résolution dans le plan peut atteindre 14 μm. En outre, il est possible de déterminer le diamètre des faisceaux nerveux dans des zones spécifiques du cerveau, comme le corps calleux, ainsi que leur orientation. Par exemple, on peut distinguer ceux à 2-4 µm de ceux à 10 µm [44].

Dans le cas des surfaces cérébrales, par exemple, le microscope à force atomique (AFM) et le microscope à conduction ionique à balayage (SICM) peuvent mesurer la forme tridimensionnelle d'une cellule en traçant sa surface à l'aide d'une sonde avec une précision de l'ordre du nanomètre [45]. Le SICM utilise le changement de courant ionique causé par le changement de distance entre le neurone et la sonde pour obtenir une image de la forme et de la charge de la surface sans toucher l'échantillon [46]. La vitesse de mesure est lente, environ 25 μm^2/min, mais la résolution de la mesure non destructive est la plus élevée par rapport aux autres méthodes [47].

La méthode de mesure des potentiels neuronaux à l'aide d'électrodes est celle qui a donné le plus de résultats pour la transmission des informations cérébrales, bien qu'il s'agisse d'une méthode de contact. L'une de ces méthodes, le patch-clamp, enregistre le comportement des ions à travers les canaux ioniques et les transporteurs. Les transporteurs de neurotransmetteurs terminent leur neurotransmission par la recapture des neurotransmetteurs libérés par les terminaisons nerveuses [48].

Un point important pour évaluer la fonction du cerveau en tant qu'instrument fondé sur des valeurs serait la manière dont les souvenirs sont stockés. En raison de l'interaction avec le monde extérieur, les décisions basées sur la mémoire détermineront le comportement d'une personne.

Jusqu'à présent, les techniques basées sur les électrodes ont été utilisées. En effet, il est possible de mesurer l'intérieur du cerveau et l'activité de neurones spécifiques. Bien qu'il s'agisse d'une méthode prometteuse, elle n'a pas encore permis de capturer les traces de mémoire dans le cerveau. Cela peut s'expliquer par le fait que la mesure elle-même affecte les nerfs, car il s'agit d'une méthode de contact. Elle n'est pas adaptée à la capture des minuscules signaux électriques des nerfs.

La méthode typique de mesure sans contact de ce signal électrique est la mesure optique.

9.1 Mesure optique des microstructures

Nombreux sont ceux qui souhaitent visualiser avec précision la forme et la couleur de minuscules échantillons à l'aide d'un microscope optique. En réalité, ce souhait ne peut être exaucé que dans un nombre limité de cas, car la taille et l'indice de réfraction ont un effet complexe sur la visibilité. Les progrès récents des techniques de calcul de la propagation de la lumière fournissent des pistes pour résoudre ce problème.L'arc-en-ciel des bulles de savon et les ailes des papillons morpho sont des exemples bien connus de l'influence de la forme et de la taille sur la couleur. En général, la couleur est fortement influencée par la partie imaginaire de l'indice de réfraction complexe. Cependant, certaines structures peuvent produire des couleurs très différentes de celles supposées par l'indice de réfraction complexe.

La forme et la taille, quant à elles, sont perçues différemment en fonction de l'indice de réfraction complexe. Il est bien connu que les informations sur l'indice de réfraction sont essentielles pour mesurer l'épaisseur d'un film. Connaître la forme et l'indice de réfraction complexe d'un micro-objet inconnu n'est rien d'autre qu'une estimation de ces paramètres à partir des informations mesurées sur la forme, la taille et la couleur.

La couleur est affectée par la structure dans une région de taille de longueur d'onde où la taille est considérée comme le domaine de résonance. Si l'échantillon est une particule, la taille de la particule dans le domaine de résonance est d'environ 1 à 10 fois la longueur d'onde. Dans l'approximation linéaire, la lumière se courbe ou se déplace en ligne droite à la surface de l'échantillon et le flux lumineux est maintenu. Cependant, pour ces particules, le flux lumineux s'étale à l'interface et cet étalement varie en fonction de la longueur d'onde. Par conséquent, la réflectance et les modèles de diffusion sont différents à différentes longueurs d'onde [49, 50, 51].

9.2 Classification des mesures optiques et de la diffusiométrie

Le principe de l'utilisation de la lumière pour voir de petits objets (le principe de la microscopie) peut être divisé mathématiquement en trois grandes catégories basées sur le degré d'approximation. La première est la méthode de traçage des rayons qui utilise le fait que la lumière se déplace en ligne droite. Il s'agit d'une approximation linéaire. La lumière traverse l'échantillon en ligne droite et l'image de l'échantillon est projetée telle quelle. Dans la tomographie à rayons X, largement utilisée en médecine, l'image tridimensionnelle originale est reconstruite à partir de cette image projetée. L'autre méthode consiste à utiliser l'imagerie par lentille. Le principe de l'optique est basé sur l'action de la transformation de Fourier de la lentille [52,53]. La transformation de Fourier n'est possible que si l'on utilise l'approximation de Fraunhofer ou une approximation similaire, l'approximation de Born du premier ordre. L'approximation de Fraunhofer est valable lorsque la mesure est effectuée à une distance suffisante par rapport à la taille de l'échantillon [54]. L'holographie, l'une des principales méthodes de mesure des formes 3D, est basée sur la même approximation et considère que la lumière réfléchie à la surface de l'échantillon est libre de se propager. La troisième méthode consiste à estimer l'image à partir du modèle de diffusion, en tenant strictement compte de l'épaisseur et de l'indice de réfraction de l'échantillon. Il s'agit de la diffusométrie. Le processus d'obtention de l'image originale est un processus d'essais et d'erreurs, et il est difficile à appliquer à moins que la géométrie soit simple. Toutefois, si l'analyse est réussie, la taille de l'objet à mesurer peut être réduite de deux ordres de grandeur par rapport aux deux autres principes, et la précision peut être améliorée de deux ordres de grandeur.La diffusiométrie est une méthode efficace pour les mesures 3D à haute résolution et à grande vitesse. Les principales méthodes conventionnelles de mesure 3D à haute résolution sont l'imagerie par lentille, l'holographie et la reproduction de phase. Les méthodes d'holographie et de reproduction de phase sont adaptées à l'obtention d'images 3D à grande vitesse, mais elles supposent l'utilisation de la transformée de Fourier, ce qui implique l'approximation de Fraunhofer. Par conséquent, lorsque la diffusion et l'absorption sont importantes, ces méthodes sont limitées à environ 100 longueurs d'onde, même si la taille de la cible de mesure est petite, et la précision n'est que d'environ 10 longueurs d'onde [55]. La diffusométrie est une évaluation numérique rigoureuse des équations de Maxwell, qui sont les principes de l'optique. Les performances sont similaires lorsque l'absorption et la diffusion sont importantes. Par conséquent, elle améliore la précision de deux ordres de grandeur dans la mesure de la forme en 3D lorsque la diffusion et l'absorption sont importantes, par rapport à l'analyse utilisant la transformée de Fourier [56].

Un autre avantage de la diffusiométrie est sa vitesse de mesure élevée. La diffusométrie est capable d'effectuer des mesures 3D à haute résolution en une seule fois sur une gamme de plusieurs longueurs d'onde. Elle est plus rapide que les mesures de super-résolution basées sur le temps de décroissance de la fluorescence, ou que les mesures d'absorption à deux photons basées sur des mesures en un seul point.

La diffusométrie est particulièrement utile pour la lumière visible et ultraviolette et pour les rayons ultraviolets très courts et les rayons X mous, où les différences d'indice de réfraction et de coefficient d'extinction entre le milieu et l'échantillon sont souvent importantes et susceptibles d'être diffusées. À des tailles d'échantillon d'environ 10 longueurs d'onde, l'approximation de Fraunhofer, principe de base de l'imagerie par lentille et de l'holographie, n'est pas valable. Lorsque l'échantillon est mince, les effets de diffraction et de diffusion sont faibles et peuvent être analysés avec cette approximation, mais lorsque l'échantillon est plus épais, cela devient plus difficile [57].

L'inconvénient de la diffusométrie est qu'elle est difficile à analyser et que l'image originale n'est pas déterminée de manière unique. En revanche, les approximations linéaires et de Fraunhofer fournissent une correspondance univoque entre l'image originale et le modèle de diffusion. Les solutions mathématiques sont fiables et rapides.

En diffusiométrie, la recherche de l'image originale à partir du motif diffusé s'appelle la résolution d'un problème inverse. L'apprentissage profond ou les méthodes des moindres carrés sont utilisés pour résoudre les problèmes inverses. Actuellement, elles sont limitées à des formes simples qui sont des colonnes et dont la section transversale de la colonne est rectangulaire, triangulaire ou elliptique.

La diffusométrie est très utile lorsque la longueur d'onde est limitée, comme dans les mesures dans le visible et l'UV, ou lorsque la destruction de l'échantillon à des longueurs d'onde courtes est un problème, comme dans les mesures de matériaux organiques avec des rayons X. Grâce à la diffusométrie, la longueur d'onde peut être allongée d'un facteur 100 pour une même résolution. En tenant compte de cet effet, la résolution est améliorée d'un facteur de plus de 10 si l'endommagement de l'échantillon est maintenu au même niveau.

La mesure optique est non destructive, sans contact et rapide. En général, plus l'énergie est élevée (longueur d'onde courte), plus la résolution est élevée, y compris pour les faisceaux d'électrons. En revanche, plus l'énergie est élevée, plus l'échantillon risque d'être détruit par la lumière mesurée [58]. Ceci est particulièrement problématique pour les matériaux organiques tels que les organismes vivants.

En raison de ce compromis, la limite à laquelle la résolution et la destruction de l'échantillon peuvent être atteintes se situe traditionnellement autour d'une longueur d'onde de 10 nm.

9.3 La diffraction cohérente et ses limites

La diffusion de la lumière par les lasers peut être considérée comme une lumière parfaitement cohérente et peut être décrite mathématiquement de manière concise. En revanche, la lumière blanche, telle que celle des lampes halogènes, nécessite un traitement qui prend en compte le degré d'incohérence, en fonction de la taille de l'échantillon et de la longueur d'onde. La raison pour laquelle la lumière cohérente convient pour mesurer la taille des objets est que les propriétés de la lumière partiellement cohérente sont indéterminées en fonction du degré d'incohérence, et que les calculs sont compliqués en fonction du degré d'incohérence.En principe, la diffusion cohérente de la lumière permet de prédire avec précision le modèle de diffusion par des méthodes de calcul optique. Bien que les propriétés des micro-échantillons varient considérablement en termes de parties réelles et imaginaires de l'indice de réfraction, de forme, de longueur verticale, de longueur horizontale, etc., un grand nombre de données expérimentales peuvent être mesurées en modifiant l'angle d'incidence et la longueur d'onde, et en mesurant la distribution de l'angle de diffusion de la transmission et de la réflexion, ainsi que la réflectance et la transmittance, de sorte qu'il est possible d'obtenir des informations approximatives.

Lorsque l'échantillon est réellement mesuré, nous sommes confrontés au problème de la lumière cohérente qui devient incohérente à l'intérieur de l'échantillon. Ce problème se pose même lorsque les diffuseurs à l'intérieur sont petits et ont peu d'effet sur le modèle de diffusion. Les calculs exacts de diffusion de la lumière supposent une lumière cohérente, ce qui conduit à des erreurs importantes.

Si la distribution de l'indice de réfraction interne d'un échantillon inconnu était connue avec précision, elle pourrait être calculée, mais l'intensité de diffusion des microdiffuseurs est faible et leur nombre est innombrable, ce qui rend difficile la mesure de la distribution. Dans ce cas, la cohérence peut servir d'indicateur. On suppose que la cohérence diminue uniformément au sein de l'échantillon. Il s'agit d'une grande approximation, mais l'accord avec l'expérience est meilleur que si rien n'est pris en compte [59].

La diffusiométrie a l'avantage de ne pas faire d'approximations, mais elle présente l'inconvénient de ne pas pouvoir obtenir la forme originale directement à partir du modèle de diffusion en utilisant une transformée de Fourier inverse ou une technique similaire. Cette technique ne peut être utilisée que lorsque la forme originale est simple ou lorsque la forme approximative est connue. Cette méthode convient à l'analyse lorsque la forme approximative est connue et qu'une seule forme de section transversale est nécessaire, comme dans le cas des neurones.

9.4 Mesure optique 3D des nerfs à grande vitesse et à haute résolution

Le principe de l'utilisation de la lumière pour voir de petits objets (principe de la microscopie) peut être divisé, comme mentionné ci-dessus, en 1. approximation linéaire, 2. approximation de Fraunhofer, et 3. méthode de solution exacte (diffusométrie). La deuxième méthode est souvent utilisée en conjonction avec la fluorescence dans la mesure des signaux nerveux. L'émission d'un fluorophore a permis d'améliorer considérablement la résolution spatiale en ne capturant que l'émission d'une seule molécule de manière résolue dans le temps : la microscopie à reconstruction optique stochastique (STORM). Cette méthode ne pouvait améliorer la résolution temporelle que si la fréquence de luminescence était élevée, et l'intensité de la lumière d'excitation, ou l'intensité de focalisation que l'échantillon pouvait supporter, limitait à la fois la vitesse et la résolution de la mesure.La troisième méthode, la diffusométrie, non seulement ne nécessite pas de marquage fluorescent, mais a également le potentiel d'améliorer de manière significative la résolution temporelle.

9.5 Appareil de mesure optique polyvalent par diffusométrie (microscope de haute précision)

L'échantillon réel est souvent très différent de l'image qui peut être représentée par l'approximation de Fraunhofer. En lumière visible et en rayons X doux, où les effets de l'absorption et de la diffusion sont importants, cette différence est notable en raison de l'absorption accrue et de la diffusion multiple à l'intérieur de l'échantillon. Dans de tels cas, la diffusométrie peut améliorer la résolution d'environ deux ordres de grandeur pour les mesures 3D de géométries simples par rapport à l'imagerie par lentille. En outre, il est possible d'effectuer des mesures avec une résolution temporelle inférieure à la milliseconde. Il s'agit d'une méthode de mesure non destructive, sans contact et simple. Il est possible de détecter rapidement et à haute résolution les changements dans la distribution de l'indice de réfraction liés à la transduction des signaux neuronaux [60,61]. Les progrès récents des techniques de calcul optique décrites ci-dessus ont permis d'analyser quantitativement la forme et la taille.La distribution de l'indice de réfraction peut être révélée si la relation entre la distribution de l'indice de réfraction dans la section transversale et le modèle de diffusion dans le champ lointain peut être calculée avec précision. Pour calculer la distribution angulaire de la lumière diffusée, nous utiliserons l'analyse rigoureuse des ondes couplées (RCWA). La raison en est que la structure interne peut être facilement prise en compte et que le modèle de diffusion du champ lointain peut être calculé directement. Bien que la RCWA ne concerne que les structures périodiques, elle peut également être appliquée aux systèmes isolés en concevant la méthode de calcul [62]. En outre, la sélection d'une structure spécifique nécessite la focalisation de la lumière sur le site de mesure, et le réglage de la relation de position entre le point de focalisation et l'échantillon a un impact significatif sur la reproductibilité, mais le contraste du modèle de diffusion peut être ajusté pour assurer la reproductibilité [63].

La combinaison des deuxième et troisième méthodes permet d'obtenir une imagerie en temps réel et des mesures à haute résolution. Il existe des exemples de diffusométrie en lumière visible de diagrammes de diffraction de neurones dans des échantillons de cerveau de chat colorés au Golgi et des échantillons de cervelet humain colorés au Weigert [43].

9.6 Utilisation de la non-linéarité optique et mesure de la différence de temps

Les mesures qui tirent parti des non-linéarités dans l'absorption et la diffusion optiques, dans l'absorption à deux photons et la diffusion Raman, sont de plus en plus utilisées. Ces techniques permettent d'augmenter la résolution spatiale par rapport aux mesures qui n'utilisent pas la non-linéarité.La limite de diffraction définit la résolution, et ces méthodes permettent d'obtenir une résolution au-delà de cette limite de diffraction. La formation d'images de ces méthodes a été étudiée dans le cadre de l'optique de Fourier. Cependant, la résolution peut être augmentée pour chaque point de mesure en utilisant la non-linéarité. Par exemple, le processus d'absorption à deux photons par un luminophore est limité aux zones où l'intensité lumineuse est forte. Il est donc possible de ne mesurer qu'une zone plus étroite que la zone de focalisation de la lumière d'une lentille pour l'absorption à un photon. Dans le cas de l'absorption à deux photons, la longueur d'onde de la lumière incidente est deux fois supérieure à la longueur d'onde de mesure. Cela permet de sélectionner une longueur d'onde avec une faible absorption et diffusion dans les organismes vivants et de mesurer en profondeur dans l'échantillon [64]. Le problème est que l'acquisition de formes 3D nécessite l'acquisition d'un grand nombre de points, ce qui tend à entraîner une mauvaise résolution temporelle.

Une autre technique est la diffusion Raman non linéaire [65]. Le Raman non linéaire est supérieur au Raman linéaire en termes de résolution temporelle et spatiale et, en sélectionnant la longueur d'onde, il est possible d'effectuer des mesures en profondeur dans les tissus cellulaires [66, 67]. [66, 67]. La constante diélectrique varie avec l'intensité du champ électrique. Si nous ne pouvons observer que les endroits où ce changement d'intensité est important, nous pouvons observer une partie de la lumière incidente qui est plus petite que le diamètre focal de la lumière incidente [65]. La diffusion Raman est généralement peu sensible et prend beaucoup de temps à mesurer. Pour résoudre ce problème, une méthode a été développée pour amplifier l'intensité du signal en faisant résonner la différence d'énergie entre deux longueurs d'onde de la lumière incidente et le mode vibrationnel de Raman de la molécule de l'échantillon.

L'autre méthode consiste à utiliser la résolution temporelle, comme dans STORM. L'émission d'un photon unique de fluorescence a un étalement limité par la diffraction qui définit la résolution de l'objectif. Toutefois, si son centre peut être évalué avec précision, il est possible d'obtenir une résolution nettement plus élevée.

Le problème des méthodes qui utilisent la non-linéarité et les mesures de différence de temps est qu'il est difficile d'augmenter la résolution temporelle. Plus l'intensité du laser est forte, meilleure est la résolution temporelle, mais plus l'échantillon est fragile.

Référence

Historique des révisions

- 2023.9.9 Version 1 2e

- 2023.7.19 Obtention du certificat SSL 1er