-Wissenschaftlicher Ansatz zur Werteerhebung-

Einleitung

Forschung zum Gehirn

Es ist sehr schwierig zu bestimmen, welche Forschung im Bereich der Wissenschaft und Technologie durchgeführt werden sollte. Die Forschung selbst ist wirklich bedeutsam und es lohnt sich, sein Leben darauf zu verwenden, da sie auch in tausend Jahren noch nützlich sein soll.

Sowohl in der Wissenschaft, die nach der Wahrheit sucht, als auch in der Technik, die auf technologische Anwendungen für die Gesellschaft abzielt, wird es wichtig sein, die immer komplexer werdende Wissenschaft und Technik in Bezug auf den Raum, die Gesellschaft und die Lebewesen zu klären. Es ist nicht schwer, sich vorzustellen, dass allein diese Überlegung ausreicht, um eine große Disziplin zu werden. Es gibt zum Beispiel die Disziplin der Wissenschaftsphilosophie.

Unter den lebenden Organismen ist die Beziehung zum Menschen ein besonders wichtiger Faktor für den Wert der Forschung. Wenn wir das Gehirn als Zentrum des menschlichen Denkens betrachten, ist es das Gehirn, das zwischen Mensch und Gesellschaft vermittelt. Das Studium des Menschen, insbesondere des Gehirns, nimmt einen wichtigen Platz in der Wissenschaft ein, auch wenn es schwierig ist, das Gehirn zu erforschen.

1. Von der Wissenschaft vorgeschlagenes Wertesystem

Abb.1 Schrödingers Katze

Die Wissenschaft hat wichtige Auswirkungen auf die Wertesysteme gehabt, wie z. B. das Unschärfeprinzip der Quantentheorie und die auf den Genen basierende Evolutionstheorie. Das Unschärfeprinzip besagt, dass die Welt nicht mechanistisch und vorherbestimmt ist, sondern voller unvorhersehbarer Möglichkeiten steckt.Die Unschärferelation besagt, dass das Produkt aus Energie und Zeit unbestimmt ist, so dass beide nicht genau gemessen werden können. Ein bekanntes Beispiel, um der Öffentlichkeit den Zusammenhang zwischen dem Unschärfeprinzip und makroskopischen Phänomenen zu erklären, ist die so genannte "Schrödingerkatze". Wenn Quantenprozesse bestimmen, ob die Katze in der Kiste tot oder lebendig ist, werden wir das erst wissen, wenn wir die Kiste öffnen. Auf makroskopischer Ebene ist so etwas unmöglich [1], aber im mikroskopischen Bereich kommt es häufig vor.

Das andere ist der so genannte Schmetterlingseffekt der Chaostheorie [2]. Selbst ein Schmetterling, der mit den Flügeln schlägt, kann sich langfristig auf das Wetter auswirken. Der Schmetterlingseffekt deutet auch darauf hin, dass die Welt unberechenbar und unsicher ist.

Penrose glaubte, dass Quanteneffekte die Wurzeln der Gehirnfunktionen bestimmen [3]. Bedeutet dies auch, dass psychologische Phänomene unvorhersehbar sind? Ich glaube, dass dies im Prinzip mit der klassischen Logik erklärt werden kann. Der Grund dafür ist, dass selbst bei Kernspins, einem Speicher, der sich leicht für Quantenberechnungen eignet, diese theoretisch nicht gut genug funktionieren, um eine Logik zu bilden [4]. Um eine Quantenberechnung durchführen zu können, muss jeder Spin in hohem Maße unabhängig sein und darf keinen äußeren Störungen ausgesetzt sein. In Flüssigkeiten sind die Kernspins in hohem Maße unabhängig und Quantenberechnungen können mit ihnen durchgeführt werden [1, 5], aber in Festkörpern ist dies schwierig. Im Gehirn, wo die Wechselwirkung in einem Festkörper stattfindet, hat man festgestellt, dass ein Effekt namens Dekohärenz, der die Unabhängigkeit der Kernspins aufhebt, von Bedeutung ist [6]. Es wäre schwierig, dichte logische Schaltungen für Quantenberechnungen im Gehirn zu konstruieren.

Abb.2 Gene und Evolution

Eine Grundlage für das wissenschaftliche Wertesystem bildete eine Reihe von Studien, die zu Darwins Evolutionstheorie (Erhaltung der Arten)[7], Nagelys Entdeckung der Chromosomen, Mendels Vererbungsgesetzen und Watsons und Cricks Entdeckung der Doppelhelix der Gene [8] führten. Sie legt nahe, dass das menschliche Potenzial an die Gene gebunden ist.Eine der Konsequenzen, die das Konzept der Gene für das soziale Denken hatte, ist die Theorie der egoistischen Gene, die besagt, dass Gene den Menschen manipulieren [9].

2. Der Wert der Erforschung des Gehirns (die Bedeutung des Gehirns als Träger von Werten)

Abb. 3 Computer und sein Gedächtnis

Friedrich Nietzsches Nihilismus und der Buddhismus haben insofern eine gemeinsame Ideologie, als sie sich beide von absoluten Wertesystemen distanzieren. Nietzsche verneinte, dass "das absolut Richtige" und "das absolut Schöne" [10]. Im Buddhismus hingegen gibt es eine große Menge an Kontemplation, die noch lange nach seinem Gründer, dem Buddha, fortbesteht. Ein Teil dieser Kontemplation ist im Herz-Sutra [11,12,13] zusammengefasst. Das Herz-Sutra relativiert alle willkürlichen menschlichen Ideen und Werte, als ob es die Erde aus dem fernen Universum betrachten würde.Wenn alle Werte relativ sind, wie es der Nihilismus und das Herz-Sutra nahelegen, dann hat das Gehirn den Status einer Quelle der Wertschöpfung über seine Existenz als Gefäß hinaus. Die Erforschung der Funktion des Gehirns ist selbst eine Suche nach der Quelle der Wertkriterien. Obwohl wir die Beziehung zwischen Gehirnfunktion und menschlichem Verhalten mit Begriffen wie Wut, Freude, Trauer und Vergnügen beschreiben können, ist es schwierig zu zeigen, was Wut, Freude, Trauer und Vergnügen sind, wenn man sie auf der zellulären Ebene betrachtet. Um die Funktion des Gehirns im Detail zu erhellen, brauchen wir eine Technologie, mit der wir die Form der Zellen und ihre Veränderungen messen können, und diese Technologie schreitet rasch voran.

Während die Quantentheorie und die genetische Theorie Erklärungen für die Prinzipien sind, nach denen Werte gebildet werden, beeinflusst das Gehirn direkt das wertorientierte Verhalten. Man kann sagen, dass es Informationen von außen verarbeitet und die Verhaltensprinzipien steuert, die verschiedene Teile des Körpers bewegen. Das sind die fünf Sinne, die Sensibilität, der Appetit und die Libido. Diese entsprechen der Firmware und den Systemdateien, die zum Starten eines Computers benötigt werden, sowie dem Betriebssystem (OS), das als Vermittler zwischen Programmen und Hardware fungiert. Auf der anderen Seite ist das Gedächtnis ein wichtiger Faktor, der die Persönlichkeit eines Menschen prägt. Auf der Grundlage des Gedächtnisses werden Verhaltensprinzipien ausgeübt. Das Gedächtnis kann in Kurzzeitspeicher und Langzeitspeicher unterteilt werden, was auf den dynamischen Direktzugriffsspeicher (Dynamic Random Access Memory, DRAM), eine Speicherart, die ein temporäres Speichermedium ist, und Festplatten bzw. optische Speichermedien, die für die langfristige Datenspeicherung geeignet sind, zutrifft. DRAM ist eine Speicherart, die sich für die vorübergehende Speicherung eignet, während Festplatten und optische Speichermedien für die langfristige Speicherung von Daten geeignet sind.

Computer bestehen aus verschiedenen IC-Chips, einschließlich DRAMs. IC-Chips sind die integrierten Schaltkreise in Computern. Ab 2022 werden IC-Chips Dutzende von Milliarden Transistoren, die Grundeinheit, enthalten [14].

Es ist die Software, die bestimmt, wie ein Computer funktioniert. Ohne Software würde er nicht funktionieren. Wenn wir wissen, welche Art von Software sich in einem Computer befindet, können wir auch wissen, wofür sie da ist und wie sie funktioniert. Software ist komplex, aber das Grundprinzip besteht aus Software, die Befehle für Addition und Subtraktion gibt, und der entsprechenden Hardware. Es ist unwahrscheinlich, dass das Gehirn so einfache Bewegungen hat, aber wir können erwarten, dass die Forschung mit der Kenntnis dieser Entsprechung beginnt.

3. Der Schlüssel zum Entschlüsseln des Gehirns

Wenn man bedenkt, dass das Gehirn einen erheblichen Einfluss auf den Wert hat, wird deutlich, dass die Hirnforschung ein wichtiger Forschungsgegenstand ist, der das Potenzial hat, Geistes- und Naturwissenschaften zu verbinden. Doch trotz der enormen Menge an Forschungsergebnissen über die Funktionsweise des Gehirns wissen wir nur sehr wenig darüber, was wichtig ist. In einem Computer ist die Speichereinheit die Speicherzelle (Speicherelement), die aus Transistoren besteht, und die Informationen werden in binären Ziffern von 01 gespeichert. Dies ist die grundlegendste Einheit, aus der ein Computer besteht. Andererseits ist nicht bekannt, wie die Information, die der 01 entspricht, im Gehirn gespeichert wird. Daher weiß man auch nur sehr vage, wie die gespeicherten Informationen verarbeitet werden [15, 16].Das offensichtlichste Gehirnphänomen im Zusammenhang mit dem Gedächtnis ist die Großmutterzelle. Wenn ein Affe das Gesicht seiner Großmutter sieht, reagiert eine bestimmte Zelle stark. Es ist, als ob eine Zelle mit einer Erinnerung korrespondiert [17]. Das menschliche Gehirn besteht aus 50 bis 100 Milliarden Neuronen [18, 19], von denen 10 Milliarden auf die Großhirnrinde entfallen [20, 21]. Für einen Spitzen-Supercomputer beträgt die Anzahl der Transistoren pro IC-Chip 10 hoch 9 [22, 23], und die Anzahl der Chips pro Computer beträgt 10 hoch 5 [23]. Die Anzahl der Transistoren beträgt dann 100.000 Milliarden (14 Potenzen von 10). Das ist eine Größenordnung mehr als die Zahl der Neuronen. Es kann jedoch nicht so viele verschiedene Dinge tun wie ein Mensch, und es scheint dem Gehirn nicht überlegen zu sein. Die Vorstellung, dass eine Zelle einem Speicher entspricht, erklärt diesen Vorteil nicht. Eine Möglichkeit ist, dass es ein komplexeres Netzwerk von Zelle zu Zelle gibt. Wenn zum Beispiel der Abstand zwischen den Zellen oder die Form der Zellen eine Informationsquelle ist, würde die Informationsmenge zunehmen.

Im Modell der Großmutterzelle und bei einer Fourier-Transformation, die den Abstand zwischen den Neuronen in ein Hologramm umwandelt, ist nicht nur das starke Signal wichtig, sondern auch das schwache Signal, das es begleitet. In diesem Fall ist die Messmethode zum Ablesen dieses schwachen Signals wichtig. Das Impulssignal des Neurons und die Form des Neurons könnten Parameter sein, und das Signal könnte durch die Form des Neurons verändert werden. Es wäre zu überlegen, ob der Schlüssel zur Information die Intensität oder der Signalabstand ist, und wie sich das Signal verzweigt.

4. Modell des Gedächtnisses und des Denkens im Gehirn

Was die Phänomenologie des Gehirns anbelangt, so gibt es eine Fülle von Forschungsergebnissen über die Übertragungswege neuronaler Informationen und die Lokalisierung von Speicherorten. Der Gedächtnismechanismus ist jedoch noch nicht verstanden. Es wird immer noch darüber diskutiert, ob es sich um einen Quantenmechanismus handelt, also ein unbestimmtes Phänomen, oder um einen klassischen Mechanismus, wie bei einer mechanischen Uhr [3].Auch die Modelle variieren, und die Perspektiven, die jedes Modell betont, sind unterschiedlich. Gabors Theorie, wonach das assoziative Gedächtnis durch ein holografisches Gedächtnis [24] erklärt werden kann, konzentriert sich auf das menschliche Gehirn, das gut mit Assoziationen umgehen kann. Eine andere Theorie besagt, dass der Geist nicht nur vom Gehirn, sondern auch von den inneren Organen beeinflusst wird [25]. Darüber hinaus gibt es Theorien, wonach es Kleinhirn- und Großhirnchips als funktionelle Strukturen gibt, die die Aktivierung anderer als neuronaler Netze steuern, und dass sie die Wurzel des Gedächtnisses sind [26, 27]. Eine andere Richtung ist der Versuch, die Funktion des Gehirns mit Hilfe eines elektrischen Modells der Berechnung zu erklären. Dies ist beispielsweise ein Versuch, den Lernprozess zu erklären und den Mechanismus zu klären, mit dem Menschen durch den Austausch von Signalen in verschiedenen Teilen des Gehirns Urteile fällen [28, 29].

Das Gehirn wird grob in Groß- und Kleinhirn unterteilt. Unter den Hirnorganen ist der Hippocampus, von dem man annimmt, dass er am Gedächtnis beteiligt ist, unterhalb des Großhirns angesiedelt. In der Nähe befindet sich der Thalamus, der als Übertragungsweg für visuelle Informationen an das Großhirn dient. Forminformationen werden Fourier-transformiert und in Dreiecke, Quadrate usw. sortiert. [30, 31, 32]. Auf diese Weise wurden zahlreiche Studien über die Übertragungswege und allgemeinen Speicherorte von Gedächtnisinformationen durchgeführt [33].

Andererseits wissen wir nicht, wo und wie Bildspeicher gespeichert und wie sie abgerufen werden [34]. Erforderlich ist ein umfassender theoretischer Rahmen, eine Reihe von Überbrückungsgesetzen, die erklären, wie mentale Ereignisse auf redundante Weise mit Gehirnaktivitätsmustern verbunden sind [35]. Es ist auch nicht klar, wo die Gedächtnisspuren (Engramme), die die Voraussetzung für diese Studie bilden, zurückbleiben. Eine einzelne Zelle reagiert zum Beispiel stark auf bestimmte Bildinformationen, wie das Gesicht einer Großmutter. Es ist jedoch nicht bekannt, wie die Information repräsentiert wird und in welcher Form sie auf zellulärer Ebene gespeichert wird. Und es stellt sich die Frage, was offengelegt werden sollte, um diesen Hinweis zu liefern. Dies führt zu den eigentlichen Fragen: Was soll gemessen werden?

Die Tatsache, dass trotz der zahlreichen Forschungsarbeiten keine Gedächtnisspuren gefunden werden können, macht es notwendig, neue Forschungsmethoden zu entwickeln.

6. Die Bedeutung der Gehirnmessung

Wir haben die Möglichkeit erörtert, dass das Gehirn, das lediglich ein Gefäß ist, als Quelle von Werten dient, aber die Erforschung des Gehirns ist noch nicht so weit fortgeschritten, dass es mit Werten in Verbindung gebracht werden kann. Das Verständnis des Gehirns erfordert eine Vielzahl von Kenntnissen. Der Wachstumsprozess des Gehirns, die Mechanismen des Gedächtnisses und der Signalübertragung sowie Modelle des Gehirns, die auf diesen Mechanismen beruhen, sind einige Beispiele. Auch das Vorhandensein oder Fehlen von Verbindungen zu anderen Organen ist wichtig. Die Prinzipien des menschlichen Verhaltens sind in der Psychologie untersucht worden, aber letztlich wird ein integriertes Verständnis des Gehirns bis hin zu seinen mikroskopischen Funktionen Diskussionen ermöglichen, die es mit Werten in Verbindung bringen[36].Wichtig ist, wie Bedeutung und Wert mit dem Gedächtnis und der Signalverarbeitung bei der neuronalen Informationsübertragung verbunden sind. Die Frage ist, wie die abstrakten Konzepte von Bedeutung und Wert auf der Signalebene dargestellt werden. So kann beispielsweise das Auftreten verschiedener Reaktionen in einem sich ständig wiederholenden Prozess auf eine gewisse Bedeutung hinweisen. Oder es kann wichtig sein, dass sich die Reaktion bei bestimmten Eingangsmustern ändert.

Betrachten wir den Fall, dass die externen Signale für die fünf Sinne immer die gleichen sind. Wenn zum Beispiel eine Person in einem Raum ohne Fenster und ohne Gegenstände, sondern nur mit Wänden eingesperrt ist und die Augen geschlossen sind, kann sie denken und kreativ sein. Ein Erwachsener, der bereits viele Erinnerungen gebildet hat, kann auch ohne Signale von außen denken und etwas schaffen. Wenn Bedeutung und Wert nur im Gehirn geschaffen werden können, würde sich der Inhalt der Signalausgabe spontan ändern, selbst wenn die externen Signale konstant sind.

Derselbe Input sollte in einer Zeitreihe unterschiedliche Reaktionen zeigen. Dies kann auf eine Neuverknüpfung oder Veränderung der Neuronen zurückzuführen sein, oder aber auf die Reproduzierbarkeit des Signals. Die Art und Weise, wie Erinnerungen gespeichert und Werte gebildet werden, ist ein wichtiger Schlüssel zur Verknüpfung von Gehirn und Gesellschaft.

Die Psychologie hat viele Prinzipien des menschlichen Verhaltens untersucht. Wir haben die Eigenschaften der Blackbox, die wir Gehirn nennen, anhand verschiedener Fallstudien untersucht. In Zukunft werden wir ein besseres Verständnis erlangen, indem wir psychologische Ereignisse mit physischen, auf dem Gehirn basierenden Beweisen abgleichen. So haben zum Beispiel Experimente mit gentechnisch veränderten Mäusen mit veränderten Gehirnen den Zusammenhang zwischen der Gehirnfunktion und bestimmten Genen aufgezeigt [37]. Darüber hinaus würde die Verknüpfung von Werten mit dem Gehirn zeigen, wie bestimmte Erinnerungen als wünschenswert angesehen werden und mit dem Verhalten verknüpft sind.

Die Messtechnik hat rasante Fortschritte gemacht, und es wurden zahlreiche Gehirnmodelle vorgeschlagen, die jedoch noch nicht den Stand erreicht haben, der zur Aufklärung des Gehirns beiträgt. Über das Gehirnmodell wird immer noch diskutiert, ob es sich um ein Quantenmodell handelt oder nicht.

Die mikroskopischen Strukturen von Hirnregionen wie Großhirn, Kleinhirn, Frontallappen, Schläfenlappen und anderen Segmenten wurden gemessen, und die allgemeine Rolle der einzelnen Regionen wird immer klarer. Messungen mit Elektroden als Messanschlüssen und Fluoreszenz als Marker für bestimmte Bereiche haben die Funktionen von Neuronen, der Grundeinheit des Gehirns, auf molekularer Ebene offenbart.

Die Erforschung des Gehirns hat also viel Aufmerksamkeit erregt. Unter den verschiedenen Aspekten des Wissens scheinen die Mechanismen des Gehirns jedoch am wenigsten verstanden zu sein. Der optische Speicher von Blu-ray speichert ein einzelnes Bit als Einheit. An jedem Punkt wird eine 1 oder 0 durch den hohen oder niedrigen Reflexionsgrad bestimmt. Wir wissen nicht einmal, wie die entsprechenden Gedächtnisspuren im Gehirn aussehen. Mit anderen Worten: Das Prinzip des Gedächtnisses ist nicht eindeutig geklärt. Wenn wir uns beispielsweise das Gesicht unserer Großmutter einprägen, zerlegt ein Computer es in 1en und 0en und speichert sie in IC-Schaltkreisen, aber welche Art von Information im Gehirn gespeichert wird, ist unbekannt. Die Magnetresonanztomographie (MRT) hat eine große Menge an Informationen geliefert. Darüber hinaus müssen die Messverfahren in vielerlei Hinsicht verbessert werden, z. B. in Bezug auf die räumliche und zeitliche Auflösung und Empfindlichkeit, die Eindringtiefe, die Differenzierung der Elemente und die Erkennung von Veränderungen der Molekularstruktur. Wir konzentrieren uns insbesondere auf die Neuronen, die Grundeinheit des Gehirns. Von Interesse sind die Verzweigungen von Signalen zu benachbarten Neuronen und die Modulation der Intensität jedes Signals innerhalb einer kurzen Zeitspanne. Wenn dies mit hoher Geschwindigkeit, hoher Empfindlichkeit, hoher Präzision, zerstörungsfrei und berührungslos gemessen werden kann, ist es sehr wahrscheinlich, dass neue Informationen gewonnen werden können.

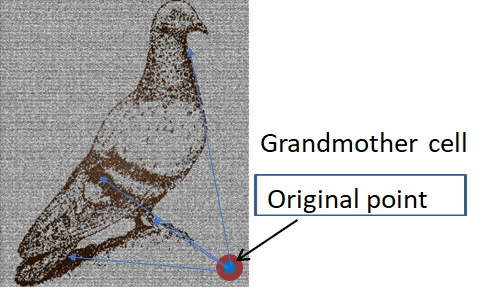

Abb.4 Bild eines Neurons der Großmutterzelle und einer Taube [16]

Abb.4 Bild eines Neurons der Großmutterzelle und einer Taube [16]Gedächtnisspuren werden als leichte Veränderungen der Neuronenform bezeichnet [38]. Aber kann sich eine einzelne Zelle solch komplexe Gesichter merken?

Es gibt ein Konzept, das Hologramme genannt wird. Beim Hologrammgedächtnis werden Informationen auf einer Oberfläche aufgezeichnet, und durch Änderung des Einfallswinkels können beispielsweise mehrere Informationen gelesen werden. Beim Licht beruht die Interferenz auf der Tatsache, dass die Wellenfront erhalten bleibt. Wenn die Signale des Gehirns in der Myelinscheide mit ihrer Kohärenz erhalten bleiben, ist es nicht verwunderlich, dass ähnliche Interferenzeffekte auftreten. Das Sehen, bei dem die Eingangsinformationen eindeutig sind, wäre am einfachsten zu analysieren. Die Sehbahn ist gut erforscht, aber es ist nicht klar, wie sie mit dem Gedächtnis verbunden ist [39].

Das Hologramm ist delokalisiert und hat einen erweiterten Speicherbereich, aber es gibt auch ein lokalisiertes Speichermodell. Wenn eine Wellenfront an einem Bild und einem starken Streupunkt, der als Referenz dient, gestreut wird, kann das ursprüngliche Bild durch Fourier-Transformation des Streumusters wiederhergestellt werden.

Bei dieser Messung der Lichtstreuung ist der Kontrast des Streumusters am höchsten, wenn sich der Brennpunkt direkt vor dem Streuer befindet. Sind zwei Streuer vorhanden, so wird das Muster durch den Abstand zwischen den beiden Streuern bestimmt. Indem man den Abstand zwischen den Streuern als Information verwendet, kann ein Gedächtnismodell konstruiert werden. Überträgt man dieses Modell auf das neuronale Gedächtnis, so kann man sich die Großmutterzelle als die zentrale Säule mit der höchsten Streuintensität unter den Mehrfachstreuern vorstellen, und der Kontrast ist am höchsten, wenn eine Welle elektrischer Signale in Phase mit der Großmutterzelle auf die Region trifft, die die Großmutterzelle und die Zelle mit ihrer Information enthält.

Das heißt, dass die Information aus dem Abstand zwischen dieser Zelle und den anderen Zellen, ausgehend von dieser Zelle, gebildet wird. Wenn dies der Fall ist, dann werden nur starke Signale beobachtet, und die wahre Information wäre in den schwachen Signalen enthalten, die zu anderen Zellen fließen.

Die Notwendigkeit der Messung schwacher Signale lässt sich aus den Großmutterzellen ableiten. Wenn schwache Signale das Gedächtnis beeinflussen, muss das Signal jedes Neurons mit hoher Empfindlichkeit gemessen werden. Da es sich bei den Signalen um Spike-Serien handelt, die sich in Intervallen in der Größenordnung von ms aneinanderreihen, ist es wichtig, sowohl eine hohe Geschwindigkeit als auch eine hohe Auflösung zu erreichen. Neuere Hochgeschwindigkeitskameras mit hoher Empfindlichkeit haben Messgeschwindigkeiten von fast 1 μs pro Bild mit hoher Empfindlichkeit und hohem Dynamikbereich erreicht[40].

Hinweis: Die Hochgeschwindigkeitskamera FASTCAM Mini AX von Photron beispielsweise ist eine Hochgeschwindigkeitskamera mit einer Aufnahmegeschwindigkeit von 20.000 Bildern pro Sekunde bei 640 x 480 Pixeln. Neben der hohen Auflösung von 12-Bit-Monochrombildern hat die Kamera eine ultrahohe Empfindlichkeit von ISO 40.000 erreicht.

Das Gehirn ist ein neuronales Netzwerk von Neuronen, die in einem gitterartigen Muster angeordnet sind. Die meisten bisherigen Studien beschränkten sich bestenfalls auf die monosynaptische Übertragung [41]. In Wirklichkeit ist selbst die monosynaptische Übertragung nicht genau analysiert worden. Die gängige Methode zur Analyse der monosynaptischen Übertragung bestand darin, eine Elektrode in ein Neuron einzuführen und die Veränderung des Potenzials zu messen. Bei dieser Methode kann die Elektrode jedoch das Signal beeinflussen. Die optische Messung ist eine vielversprechende Methode zur berührungslosen Messung. Eine schnelle, hochauflösende Methode zur 3D-Messung durch Holographie oder Zwei-Photonen-Absorption wird derzeit untersucht[42].

Neben der Holografie und der Zwei-Photonen-Absorption gibt es weitere Methoden zur optischen Messung von Signalen mehrerer Neuronen, die die Scatterometrie verwenden [43].

Hologramme sind insofern überlegen, als sie eine einfache Kontrolle der räumlichen Lichtsammlung und der Detektionsposition ermöglichen. Die Zwei-Photonen-Absorption ist einzigartig, da sie tief im Gehirn messen kann. Andererseits ist die Scatterometrie in Bezug auf Auflösung und Messgeschwindigkeit überlegen.

Die Methode zur Messung von Signalen im Gehirn hängt von dem zu messenden Objekt ab. Das Gehirn kann in drei Kategorien eingeteilt werden: die obere Oberfläche, einige Millimeter tief und das gesamte Gehirn. Darüber hinaus sind die Auflösung und die Messgeschwindigkeit wichtige Faktoren. Die Messmethoden können als berührungslos, berührend oder zerstörend klassifiziert werden.

Techniken, mit denen das gesamte Gehirn gemessen werden kann, sind Röntgen-CT und MRT. Mit diesen Verfahren kann die Struktur des gesamten Gehirns nichtinvasiv gemessen werden. Insbesondere die MRT kann nicht nur die Struktur, sondern auch die molekulare Beweglichkeit erfassen. Seine Auflösung in der Ebene kann 14 μm betragen. Darüber hinaus kann der Durchmesser von Nervenbündeln in bestimmten Hirnregionen, wie z. B. dem Corpus callosum, bestimmt werden, ebenso wie ihre Ausrichtung. So kann man beispielsweise zwischen denen bei 2-4 µm und denen bei 10 µm unterscheiden [44].

Bei Hirnoberflächen können beispielsweise das Rasterkraftmikroskop (AFM) und das Raster-Ionenleitmikroskop (SICM) die dreidimensionale Form einer Zelle messen, indem sie ihre Oberfläche mit einer Sonde mit Nanometergenauigkeit abtasten [45]. Das SICM nutzt die Änderung des Ionenstroms, die durch die Änderung des Abstands zwischen dem Neuron und der Sonde verursacht wird, um die Oberflächenform und -ladung abzubilden, ohne die Probe zu berühren [46]. Die Messgeschwindigkeit ist langsam, etwa 25 μm^2/min, aber die Auflösung bei der zerstörungsfreien Messung ist die höchste im Vergleich zu anderen Methoden [47].

Die Methode der Messung neuronaler Potenziale mit Elektroden hat die meisten Ergebnisse für die Informationsübertragung im Gehirn erzielt, obwohl es sich um eine Kontaktmethode handelt. Eine solche Methode, die Patch-Clamp-Methode, erfasst das Verhalten von Ionen durch Ionenkanäle und Transporter. Neurotransmitter-Transporter beenden ihre Neurotransmission durch die Wiederaufnahme von Neurotransmittern, die von den Nervenendigungen freigesetzt werden [48].

Ein wichtiger Punkt für die Bewertung der Funktion des Gehirns als wertebasiertes Instrument wäre, wie Erinnerungen gespeichert werden. Infolge der Interaktion mit der Außenwelt bestimmen die auf dem Gedächtnis basierenden Entscheidungen das Verhalten einer Person.

Bisher wurden elektrodenbasierte Techniken verwendet. Dies liegt daran, dass es möglich ist, das Innere des Gehirns zu messen und die Aktivität bestimmter Neuronen zu erfassen. Obwohl es sich um eine vielversprechende Methode handelt, ist es bisher nicht gelungen, Gedächtnisspuren im Gehirn zu erfassen. Ein Grund dafür könnte sein, dass die Messung selbst die Nerven beeinträchtigt, da es sich um eine Kontaktmethode handelt. Sie ist nicht geeignet, die winzigen elektrischen Signale der Nerven zu erfassen.

Die typische Methode zur berührungslosen Messung dieser elektrischen Signale ist die optische Messung.

9.1 Optische Messung von Mikrostrukturen

Es ist der Wunsch vieler Menschen, Form und Farbe kleinster Proben mit einem Lichtmikroskop genau betrachten zu können. In der Realität lässt sich dieser Wunsch nur in wenigen Fällen erfüllen, da Größe und Brechungsindex einen komplexen Einfluss auf die Sichtbarkeit haben. Jüngste Fortschritte bei den Techniken zur Berechnung der Lichtausbreitung liefern Anhaltspunkte zur Lösung dieses Problems.Bekannte Beispiele für den Einfluss von Form und Größe auf die Farbe sind der Regenbogen von Seifenblasen und die Flügel von Morpho-Schmetterlingen. Normalerweise wird die Farbe stark durch den Imaginärteil des komplexen Brechungsindexes beeinflusst. Einige Strukturen können jedoch Farben erzeugen, die sich von denen unterscheiden, die sich aus dem komplexen Brechungsindex ergeben.

Form und Größe hingegen werden in Abhängigkeit vom komplexen Brechungsindex unterschiedlich wahrgenommen. Es ist bekannt, dass Informationen über den Brechungsindex für die Messung der Schichtdicke unerlässlich sind. Die Kenntnis der Form und des komplexen Brechungsindex eines unbekannten Mikroobjekts ist nichts anderes als eine Schätzung dieser Parameter anhand der gemessenen Form-, Größen- und Farbinformationen.

Die Farbe wird durch die Struktur in einem Wellenlängenbereich beeinflusst, wobei die Größe als Resonanzbereich bezeichnet wird. Handelt es sich bei der Probe um ein Partikel, beträgt die Partikelgröße im Resonanzbereich etwa das 1- bis 10-fache der Wellenlänge. Bei der linearen Annäherung wird das Licht an der Probenoberfläche gebogen oder läuft geradeaus, und der Lichtfluss bleibt erhalten. Bei diesen Partikeln breitet sich der Lichtstrom jedoch an der Grenzfläche aus, und diese Ausbreitung variiert mit der Wellenlänge. Daher sind die Reflexions- und Streuungsmuster bei verschiedenen Wellenlängen unterschiedlich [49, 50, 51].

9.2 Klassifizierung der optischen Messung und Scatterometrie

Das Prinzip, Licht zu nutzen, um kleine Objekte zu sehen (das Prinzip der Mikroskopie), kann mathematisch in drei große Kategorien unterteilt werden, die auf dem Grad der Annäherung basieren. Die eine ist die Methode der Strahlenverfolgung, die sich auf die Tatsache stützt, dass sich das Licht in einer geraden Linie ausbreitet. Dies ist eine lineare Annäherung. Das Licht bewegt sich gerade durch die Probe, und das Bild der Probe wird so projiziert, wie es ist. Bei der Röntgen-CT, die in der Medizin weit verbreitet ist, wird das ursprüngliche dreidimensionale Bild aus diesem projizierten Bild rekonstruiert. Die andere Methode ist die Verwendung von Linsenbildern. Das Prinzip der Optik basiert auf der Fourier-Transformation der Linse [52,53]. Und die Fourier-Transformation ist nur möglich, wenn die Fraunhofer-Approximation oder eine ähnliche Approximation, die Born-Approximation erster Ordnung, verwendet wird. Die Fraunhofer-Näherung ist gültig, wenn die Messung im Vergleich zur Probengröße ausreichend weit entfernt ist [54]. Die Holographie, eine der wichtigsten Methoden zur Messung von 3D-Formen, basiert auf der gleichen Näherung und berücksichtigt, dass sich das an der Probenoberfläche reflektierte Licht frei ausbreiten kann. Die dritte Methode ist eine Schätzung des Bildes aus dem Streumuster, wobei die Dicke und der Brechungsindex der Probe streng berücksichtigt werden. Sie wird als Scatterometrie bezeichnet. Das Verfahren zur Ermittlung des Originalbildes ist ein Versuch und Irrtum und lässt sich nur schwer anwenden, wenn die Geometrie einfach ist. Wenn die Analyse jedoch erfolgreich ist, kann die Größe des zu messenden Objekts im Vergleich zu den anderen beiden Prinzipien um zwei Größenordnungen verringert und die Genauigkeit um zwei Größenordnungen verbessert werden.Die Scatterometrie ist eine effektive Methode für hochauflösende und schnelle 3D-Messungen. Die wichtigsten konventionellen hochauflösenden 3D-Messverfahren sind Linsenabbildung, Holografie und Phasenreproduktion. Holographie- und Phasenreproduktionsmethoden eignen sich für die Gewinnung von 3D-Bildern mit hoher Geschwindigkeit, aber sie setzen die Verwendung der Fourier-Transformation voraus, was die Annahme der Fraunhofer-Näherung bedingt. Wenn Streuung und Absorption groß sind, sind diese Methoden daher auf etwa 100 Wellenlängen beschränkt, selbst wenn das Messobjekt klein ist, und die Genauigkeit beträgt nur etwa 10 Wellenlängen [55]. Bei der Scatterometrie handelt es sich um eine strenge numerische Auswertung der Maxwellschen Gleichungen, die die Grundlagen der Optik darstellen. Die Leistung ist ähnlich, wenn Absorption und Streuung groß sind. Daher verbessert sie die Genauigkeit bei der 3D-Formmessung um zwei Größenordnungen, wenn Streuung und Absorption groß sind, im Vergleich zur Analyse mit der Fourier-Transformation [56].

Ein weiterer Vorteil der Scatterometrie ist ihre hohe Messgeschwindigkeit. Mit der Scatterometrie können hochauflösende 3D-Messungen in einem einzigen Schuss über einen Bereich von mehreren bis mehreren Dutzend Wellenlängen durchgeführt werden. Sie ist schneller als superauflösende Messungen, die auf der Fluoreszenzabklingzeit beruhen, oder Zwei-Photonen-Absorptionsmessungen, die auf Einzelpunktmessungen beruhen.

Die Scatterometrie ist besonders nützlich für sichtbares und ultraviolettes Licht sowie für sehr kurze ultraviolette und weiche Röntgenstrahlen, bei denen die Unterschiede im Brechungsindex und im Extinktionskoeffizienten zwischen Medium und Probe oft groß und anfällig für Streuung sind. Bei Probengrößen von etwa 10 Wellenlängen ist die Fraunhofer-Näherung, das Grundprinzip der Linsenabbildung und Holografie, nicht gültig. Wenn die Probe dünn ist, sind die Beugungs- und Streuungseffekte gering und können mit dieser Näherung analysiert werden, aber wenn die Probe dicker ist, wird es schwieriger [57].

Der Nachteil der Scatterometrie ist, dass sie schwierig zu analysieren ist und das ursprüngliche Bild nicht eindeutig bestimmt werden kann. Die lineare und die Fraunhofer-Approximation hingegen liefern eine Eins-zu-eins-Entsprechung zwischen dem Originalbild und dem Streumuster. Die mathematischen Lösungen sind zuverlässig und schnell.

In der Scatterometrie wird das Finden des Originalbildes aus dem Streumuster als Lösung eines inversen Problems bezeichnet. Zur Lösung inverser Probleme werden Methoden des Deep Learning oder der kleinsten Quadrate verwendet. Derzeit sind sie auf einfache Formen beschränkt, die säulenförmig sind und einen rechteckigen, dreieckigen oder elliptischen Querschnitt der Säule haben.

Die Scatterometrie ist leistungsstark, wenn die Wellenlänge begrenzt ist, wie bei Messungen im sichtbaren und UV-Bereich, oder wenn die Zerstörung der Probe bei kurzen Wellenlängen ein Problem darstellt, wie bei der Messung von organischen Materialien mit Röntgenstrahlen. Mit der Scatterometrie kann die Wellenlänge bei gleicher Auflösung um den Faktor 100 verlängert werden. Berücksichtigt man diesen Effekt, verbessert sich die Auflösung um einen Faktor von mehr als 10, wenn die Probenschädigung gleich bleibt.

Die optische Messung ist zerstörungsfrei, berührungslos und schnell. Im Allgemeinen gilt: Je höher die Energie (kürzere Wellenlänge), desto höher die Auflösung, auch bei Elektronenstrahlen. Je höher die Energie, desto wahrscheinlicher ist es jedoch, dass die Probe durch das gemessene Licht zerstört wird [58]. Dies ist insbesondere bei organischen Materialien wie lebenden Organismen problematisch.

Aufgrund dieses Zielkonflikts liegt die Grenze, bei der sowohl die Auflösung als auch die Zerstörung der Probe erreicht werden kann, üblicherweise bei einer Wellenlänge von 10 nm.

9.3 Kohärente Beugung und ihre Beschränkungen

Die Lichtstreuung von Lasern kann als perfekt kohärentes Licht betrachtet werden und lässt sich mathematisch präzise beschreiben. Bei weißem Licht, z. B. von Halogenlampen, ist dagegen eine Behandlung erforderlich, die den Grad der Inkohärenz berücksichtigt, der von der Probengröße und der Wellenlänge abhängt. Der Grund, warum sich kohärentes Licht für die Messung der Größe von Objekten eignet, liegt darin, dass die Eigenschaften von teilkohärentem Licht im Grad der Inkohärenz unbestimmt sind und die Berechnungen je nach Grad der Inkohärenz kompliziert sind.Im Prinzip lässt sich mit kohärenter Lichtstreuung das Streumuster durch optische Berechnungsmethoden genau vorhersagen. Obwohl die Eigenschaften von Mikroproben in Bezug auf Real- und Imaginärteil des Brechungsindex, Form, vertikale Länge, horizontale Länge usw. sehr unterschiedlich sind, kann eine große Anzahl experimenteller Daten gemessen werden, indem der Einfallswinkel und die Wellenlänge geändert und die Streuwinkelverteilung von Transmission und Reflexion sowie Reflexions- und Transmissionsgrad gemessen werden, so dass grobe Informationen gewonnen werden können.

Wenn die Probe tatsächlich gemessen wird, stehen wir vor dem Problem, dass kohärentes Licht innerhalb der Probe inkohärent wird. Dieses Problem tritt selbst dann auf, wenn die Streuer in der Probe klein sind und das Streumuster kaum beeinflussen. Exakte Lichtstreuungsberechnungen gehen von kohärentem Licht aus, was zu großen Fehlern führt.

Wäre die interne Brechungsindexverteilung einer unbekannten Probe genau bekannt, könnte sie berechnet werden, aber die Streuintensität der Mikrostreuer ist klein und ihre Anzahl ist unzählig, so dass es schwierig ist, die Verteilung zu messen. In diesem Fall kann die Kohärenz als Indikator verwendet werden. Es wird angenommen, dass die Kohärenz innerhalb der Probe gleichmäßig abnimmt. Dies ist eine große Annäherung, aber die Übereinstimmung mit dem Experiment ist besser, als wenn überhaupt nichts berücksichtigt wird [59].

Die Scatterometrie hat den Vorteil, dass sie keine Näherungen vornimmt, hat aber den Nachteil, dass die ursprüngliche Form nicht direkt aus dem Streumuster mittels einer inversen Fourier-Transformation oder ähnlichem gewonnen werden kann. Diese Technik kann nur verwendet werden, wenn die ursprüngliche Form einfach ist oder wenn die ungefähre Form bekannt ist. Diese Methode eignet sich für die Analyse, wenn die ungefähre Form bekannt ist und nur eine Querschnittsform benötigt wird, wie im Fall der Neuronen.

9.4 Hochgeschwindigkeits- und hochauflösende optische 3D-Vermessung von Nerven

Das Prinzip der Betrachtung kleiner Objekte mit Hilfe von Licht (das Prinzip der Mikroskopie) lässt sich, wie bereits erwähnt, in 1. lineare Näherung, 2. Fraunhofer-Näherung und 3. exakte Lösungsmethode (Scatterometrie) unterteilen. Die zweite Methode wird häufig in Verbindung mit Fluoreszenz bei der Messung von Nervensignalen verwendet. Die Emission eines Fluorophors hat zu einer erheblichen Verbesserung der räumlichen Auflösung geführt, indem nur die Emission eines einzelnen Moleküls zeitaufgelöst erfasst wurde: stochastische optische Rekonstruktionsmikroskopie (STORM). Diese Methode konnte die zeitliche Auflösung nicht verbessern, es sei denn, die Frequenz der Lumineszenz war hoch, und die Intensität des Anregungslichts oder die Fokussierungsintensität, der die Probe standhalten konnte, begrenzte sowohl die Geschwindigkeit als auch die Auflösung der Messung.Die dritte Methode, die Scatterometrie, erfordert nicht nur keine Fluoreszenzmarkierung, sondern hat auch das Potenzial, die zeitliche Auflösung erheblich zu verbessern.

9.5 Vielseitiges optisches Messgerät durch Scatterometrie (Hochpräzisionsmikroskop)

Die tatsächliche Probe unterscheidet sich oft stark von dem Bild, das durch die Fraunhofer-Approximation dargestellt werden kann. Bei sichtbarem Licht und weicher Röntgenstrahlung, wo die Auswirkungen von Absorption und Streuung signifikant sind, ist diese Diskrepanz aufgrund von verstärkter Absorption und Mehrfachstreuung innerhalb der Probe bemerkenswert. In solchen Fällen kann die Scatterometrie die Auflösung bei 3D-Messungen von einfachen Geometrien im Vergleich zur Linsenabbildung um etwa zwei Größenordnungen verbessern. Darüber hinaus ist es möglich, mit einer Zeitauflösung von weniger als einer Millisekunde zu messen. Dies ist eine zerstörungsfreie, berührungslose und einfache Messmethode. Die hochauflösende und schnelle Erkennung von Veränderungen in der Brechungsindexverteilung, die mit der neuronalen Signaltransduktion zusammenhängen, ist möglich [60,61]. Jüngste Fortschritte bei den oben beschriebenen optischen Berechnungstechniken haben es möglich gemacht, Form und Größe quantitativ zu analysieren.Die Brechungsindexverteilung lässt sich aufdecken, wenn die Beziehung zwischen der Brechungsindexverteilung im Querschnitt und dem Streumuster im Fernfeld genau berechnet werden kann. Als Methode zur Berechnung der Winkelverteilung des gestreuten Lichts wird die Rigorose Coupled-Wave-Analyse (RCWA) verwendet. Der Grund dafür ist, dass die innere Struktur leicht berücksichtigt werden kann und das Streumuster des Fernfeldes direkt berechnet werden kann. Obwohl die RCWA nur periodische Strukturen behandelt, kann sie auch auf isolierte Systeme angewandt werden, wenn die Berechnungsmethode entwickelt wird [62]. Darüber hinaus erfordert die Auswahl einer bestimmten Struktur die Fokussierung des Lichts auf die Messstelle, und die Einstellung des Positionsverhältnisses zwischen dem Fokuspunkt und der Probe hat einen erheblichen Einfluss auf die Reproduzierbarkeit, aber der Kontrast des Streumusters kann angepasst werden, um die Reproduzierbarkeit sicherzustellen [63].

Die Kombination der zweiten und dritten Methode ermöglicht sowohl die Bildgebung in Echtzeit als auch hochauflösende Messungen. Es gibt Beispiele für die Scatterometrie mit sichtbarem Licht von Beugungsmustern von Neuronen in Golgi gefärbten Großhirnproben von Katzen und Weigert gefärbten Kleinhirnproben von Menschen [43].

9.6 Nutzung der optischen Nichtlinearität und Zeitdifferenzmessung

Zunehmend werden Messungen eingesetzt, die sich die Nichtlinearität der optischen Absorption und Streuung, der Zwei-Photonen-Absorption und der Raman-Streuung, zunutze machen. Diese Techniken können die räumliche Auflösung im Vergleich zu Messungen, die keine Nichtlinearität nutzen, erhöhen.Die Beugungsgrenze definiert die Auflösung, und es handelt sich um Methoden, die eine Auflösung jenseits dieser Beugungsgrenze ermöglichen. Die Bilderzeugung bei diesen Methoden wurde im Rahmen der Fourier-Optik untersucht. Die Auflösung kann jedoch für jeden Messpunkt durch Ausnutzung der Nichtlinearität erhöht werden. So ist beispielsweise der Prozess der Zwei-Photonen-Absorption durch einen Leuchtstoff auf Bereiche mit starker Lichtintensität beschränkt. Dadurch ist es möglich, nur einen schmaleren Bereich zu messen als den lichtfokussierenden Bereich einer Linse für die Ein-Photonen-Absorption. Bei der Zwei-Photonen-Absorption ist die Wellenlänge des einfallenden Lichts doppelt so groß wie die Messwellenlänge. Dadurch ist es möglich, eine Wellenlänge mit geringer Absorption und Streuung in lebenden Organismen zu wählen und tief in der Probe zu messen [64]. Das Problem besteht darin, dass die Erfassung von 3D-Formen die Aufnahme einer großen Anzahl von Punkten erfordert, was tendenziell zu einer schlechten zeitlichen Auflösung führt.

Eine weitere Technik ist die nichtlineare Raman-Streuung [65]. Die nichtlineare Raman-Streuung ist der linearen Raman-Streuung sowohl in der zeitlichen als auch in der räumlichen Auflösung überlegen, und durch die Wahl der Wellenlänge ist es möglich, tief im Zellgewebe zu messen. [66, 67]. Die Dielektrizitätskonstante variiert mit der Intensität des elektrischen Feldes. Wenn wir nur dort beobachten können, wo diese Intensitätsänderung groß ist, können wir möglicherweise einen Teil des einfallenden Lichts beobachten, der kleiner ist als der Fokusdurchmesser des einfallenden Lichts [65]. Die Raman-Streuung hat im Allgemeinen eine geringe Empfindlichkeit und erfordert eine lange Messzeit. Um dieses Problem zu lösen, wurde eine Methode zur Verstärkung der Signalintensität entwickelt, indem die Energiedifferenz zwischen zwei Wellenlängen des einfallenden Lichts und der Raman-Schwingungsform des Probenmoleküls in Resonanz gebracht wird.

Die andere Methode ist die Verwendung der Zeitauflösung, wie bei STORM. Die Emission von Einzelphotonen-Fluoreszenz hat eine beugungsbegrenzte Streuung, die die Auflösung der Linse bestimmt. Wenn jedoch das Zentrum genau ausgewertet werden kann, lässt sich eine wesentlich höhere Auflösung erzielen.

Das Problem bei Methoden, die Nichtlinearität und Zeitdifferenzmessungen verwenden, ist, dass es schwierig ist, die zeitliche Auflösung zu erhöhen. Je stärker die Laserintensität ist, desto besser ist die zeitliche Auflösung, aber desto empfindlicher ist die Probe.

Referenz

Revisionsgeschichte

- 2023.9.9 Version 1 2.

- 2023.7.19 SSL-Zertifikat erhalten 1.