--Enfoque científico de la investigación de valores--

Introducción

Investigación sobre el cerebro

Es muy difícil determinar qué investigación debe realizarse en el campo de la ciencia y la tecnología. La investigación en sí es realmente significativa y merece la pena dedicarle la vida, ya que se espera que sea útil incluso dentro de mil años.

Tanto en la ciencia, que busca la verdad, como en la ingeniería, cuyo objetivo son las aplicaciones tecnológicas a la sociedad, será importante aclarar la ciencia y la tecnología, cada vez más complejas, en relación con el espacio, la sociedad y los seres vivos. No es difícil imaginar que esta consideración baste por sí sola para convertirse en una disciplina importante. Por ejemplo, existe la disciplina de la filosofía de la ciencia.

Entre los organismos vivos, la relación con las personas es un factor especialmente importante en el valor de la investigación. Si consideramos que el cerebro es el centro del pensamiento humano, es el cerebro el que media entre las personas y la sociedad. El estudio de las personas, especialmente del cerebro, ocupa un lugar importante en el mundo académico, a lo que se añade la dificultad de dilucidar el cerebro.

1. Sistema de valores sugerido por la ciencia

Fig.1 El gato de Schrödinger

La ciencia ha tenido importantes implicaciones para los sistemas de valores, como el principio de incertidumbre de la teoría cuántica y la teoría de la evolución basada en los genes. El principio de incertidumbre sugería que el mundo no es mecanicista y predestinado, sino que está lleno de posibilidades impredecibles.Según el principio de incertidumbre, existe una indeterminación en el producto de la energía y el tiempo, de modo que ambos no pueden medirse con exactitud. Un ejemplo muy conocido para explicar al gran público la relación entre el principio de incertidumbre y los fenómenos macroscópicos es el conocido como "gato de Schrödinger". Si los procesos cuánticos determinan si el gato de la caja está vivo o muerto, no lo sabremos hasta que abramos la caja. A nivel macroscópico, estas cosas son imposibles [1], pero en el ámbito microscópico ocurren con frecuencia.

El otro es lo que se conoce como efecto mariposa en la teoría del caos[2]. Incluso el aleteo de una mariposa puede influir a largo plazo en el clima. El efecto mariposa también sugiere que el mundo es impredecible e incierto.

Penrose creía que los efectos cuánticos gobiernan las raíces del funcionamiento del cerebro [3]. ¿Implica esto también fenómenos psicológicos impredecibles? Creo que en principio puede explicarse mediante la lógica clásica. La razón es que incluso en los espines nucleares, una memoria que es fácilmente susceptible de computación cuántica, no funciona teóricamente lo suficientemente bien como para constituir una lógica [4]. Para realizar la computación cuántica, cada espín debe ser altamente independiente y no estar sujeto a perturbaciones externas. En los líquidos, los espines nucleares son altamente independientes y se pueden realizar cálculos cuánticos con ellos [1, 5], pero en los sólidos es difícil. En el cerebro, donde la interacción es en el sólido, se ha descubierto un efecto llamado decoherencia, que rompe la independencia de los espines nucleares [6]. Sería difícil construir circuitos lógicos densos para la computación cuántica en el cerebro.

Fig.2 Genes y evolución

Uno de los fundamentos del sistema de valores científicos lo proporcionaron una serie de estudios que condujeron a la teoría de la evolución de Darwin (conservación de las especies)[7], el descubrimiento de los cromosomas por Nagely, las leyes de la herencia de Mendel y el descubrimiento de la doble hélice de los genes por Watson y Crick [8]. Sugiere que el potencial humano está ligado a los genes.Una de las consecuencias que el concepto de genes ha traído al pensamiento social es la teoría del gen egoísta, según la cual los genes manipulan a los humanos [9].

2. El valor de la exploración del cerebro (la importancia del cerebro como recipiente de valor)

Fig. 3 Ordenador y su memoria

El nihilismo de Friedrich Nietzsche y el budismo comparten una ideología común en el sentido de que ambos se alejan de los sistemas de valores absolutos. Nietzsche negaba que "absolutamente esto es correcto" y "absolutamente bello" [10]. El budismo, por su parte, tiene una gran cantidad de contemplación que continúa mucho después de su fundador, Buda. Parte de esa contemplación se resume en el Sutra del Corazón[11,12,13]. El Sutra del Corazón relativiza todas las ideas y valores humanos arbitrarios como si contemplara la Tierra desde el universo distante.Si todo valor es relativo, como sugieren el nihilismo y el Sutra del Corazón, entonces el cerebro tiene el estatus de fuente de creación de valor más allá de su existencia como recipiente. Elucidar la función del cerebro es en sí mismo una búsqueda de la fuente de criterios de valor. Aunque podemos describir la relación entre la función cerebral y el comportamiento humano en términos de ira, alegría, pena y placer, es difícil mostrar qué son la ira, la alegría, la pena y el placer cuando se observan a nivel celular. Para dilucidar la función cerebral en detalle, necesitamos tecnología que permita medir la forma de las células y sus cambios, y esta tecnología avanza rápidamente.

2.2 Cerebro y sistema de valores

Mientras que la teoría cuántica y la teoría genética son explicaciones de los principios por los que se forman los valores, el cerebro influye directamente en el comportamiento basado en valores. Puede decirse que procesa la información del exterior y rige los principios de comportamiento que mueven diversas partes del cuerpo. Se trata de los cinco sentidos de la sensibilidad, el apetito y la libido. Corresponden al firmware y a los archivos de sistema necesarios para poner en marcha un ordenador, así como al sistema operativo (SO) que actúa como intermediario entre los programas y el hardware. Por otro lado, la memoria es un factor importante que configura la personalidad de una persona. Sobre la base de la memoria se ejercen los principios del comportamiento. La memoria puede dividirse en memoria temporal y memoria a largo plazo, lo que puede aplicarse a la memoria dinámica de acceso aleatorio (DRAM), un tipo de memoria que es un dispositivo de almacenamiento temporal, y a los discos duros y medios de almacenamiento óptico, que son memorias adecuadas para el almacenamiento de datos a largo plazo, respectivamente. La DRAM es un tipo de memoria adecuado para el almacenamiento temporal, mientras que los discos duros y los medios de almacenamiento óptico son adecuados para el almacenamiento de datos a largo plazo.Los ordenadores se componen de varios chips IC, entre ellos las DRAM. Los chips IC son los circuitos integrados de los ordenadores. En 2022, los chips IC contendrán decenas de miles de millones de transistores, la unidad básica [14].

El software es lo que determina cómo funciona un ordenador. Sin software, no funcionaría. Si sabemos qué tipo de software hay en un ordenador, podemos saber para qué sirve y cómo funciona. El software es complejo, pero el principio básico consiste en un software que da órdenes para sumar y restar, y el hardware correspondiente. Es poco probable que el cerebro tenga movimientos tan sencillos, pero podemos esperar que la investigación comience por conocer esta correspondencia.

3. La clave para descifrar el cerebro

Si consideramos que el cerebro tiene un impacto significativo en el valor, podemos ver que la investigación del cerebro es un tema de investigación importante con el potencial de conectar las humanidades y la ciencia. Sin embargo, a pesar de la ingente cantidad de investigaciones sobre el funcionamiento del cerebro, sabemos muy poco sobre lo que es importante. En un ordenador, la unidad de almacenamiento es la célula de memoria (elemento de almacenamiento) formada por transistores, y la información se almacena en dígitos binarios de 01. Ésta es la unidad más básica que compone un ordenador. En cambio, se desconoce cómo se almacena la información correspondiente al 01 en el cerebro. Por lo tanto, sólo se sabe más vagamente cómo se procesa la información almacenada [15, 16].El fenómeno cerebral más obvio relacionado con la memoria es la célula de la abuela. Cuando un mono ve la cara de una abuela, una célula específica responde fuertemente. Es como si una célula correspondiera a un recuerdo [17]. El número de neuronas que componen el cerebro humano oscila entre 50.000 y 100.000 millones [18, 19], 10.000 millones de las cuales pertenecen a la corteza cerebral [20, 21]. Para un superordenador de alto nivel, el número de transistores por chip de CI es de 10 a la 9ª potencia [22, 23], y el número de chips por ordenador es de 10 a la 5ª potencia [23]. El número de transistores es entonces de 100.000 billones (14 potencias de 10). Se trata de un orden de magnitud superior al número de neuronas. Sin embargo, no es capaz de hacer tantas cosas diferentes como un ser humano, y no parece ser superior al cerebro. La idea de que una célula corresponde a una memoria no explica esta ventaja. Una posibilidad es que exista una red más compleja, de célula a célula. Por ejemplo, si la distancia entre células o la forma de las células es una fuente de información, la cantidad de información aumentaría.

En el modelo de célula abuela, y si existe una transformación similar a la transformada de Fourier desde la distancia entre neuronas a un holograma, entonces no sólo es importante la señal fuerte, sino también la señal débil que la acompaña. Teniendo esto en cuenta, el método de medición para leer esta señal débil es importante. La señal de impulso de la neurona y la forma de la neurona podrían ser parámetros, y la señal podría verse modificada por la forma de la neurona. Habría que considerar si la clave de la información es la intensidad o el espaciado de la señal, y cómo se ramifica la señal.

4. Modelo de memoria y pensamiento cerebral

En cuanto a la fenomenología del cerebro, hay una gran cantidad de investigaciones sobre las vías de transmisión de la información neuronal y dónde se localizan las ubicaciones de la memoria. Sin embargo, no se comprende el mecanismo de la memoria. Aún se debate si el mecanismo es cuántico, un fenómeno indeterminado, o clásico, como un reloj mecánico [3].Los modelos también varían, y las perspectivas que cada modelo enfatiza son diferentes. La teoría de Gabor de que la memoria asociativa puede explicarse por la memoria holográfica [24] se centra en el cerebro humano, que es bueno en asociaciones. Otra teoría es que la mente no sólo está influida por el cerebro, sino también por los órganos internos [25]. Además, hay teorías que sostienen que existen chips cerebelosos y cerebrales como estructuras funcionales que controlan la activación distintas de las redes neuronales, y que son la raíz de la memoria [26, 27]. Otra dirección es intentar explicar la función del cerebro utilizando un modelo eléctrico de computación. Así, por ejemplo, se intenta explicar el proceso de aprendizaje y aclarar el mecanismo por el que los seres humanos emiten juicios mediante el intercambio de señales en diversas partes del cerebro [28, 29].

5. Huellas de memoria: Engramas

El cerebro se divide a grandes rasgos en cerebro y cerebelo. Entre los órganos cerebrales, se cree que el hipocampo está implicado en la memoria y se encuentra debajo del cerebro. Cerca se encuentra el tálamo, que sirve de vía de transmisión de la información visual al cerebro. La información sobre la forma se transforma en Fourier y se clasifica en triángulos, cuadrados, etc. [30, 31, 32]. De este modo, se han realizado muchos estudios sobre las vías y las ubicaciones generales de almacenamiento de la información de la memoria [33].Por otro lado, no sabemos dónde y cómo se almacenan los recuerdos de imágenes y cómo se recuerdan [34]. Lo que hace falta es encontrar un marco teórico completo, un conjunto de leyes puente que expliquen cómo se relacionan los acontecimientos mentales con los patrones de actividad cerebral de forma redundante [35]. Tampoco está claro dónde quedan los rastros de memoria (Engram) que constituyen la premisa de este estudio. Por ejemplo, una sola célula responde fuertemente a información específica de una imagen, como la cara de una abuela. Sin embargo, se desconoce cómo se representa la información y en qué forma se almacena a nivel celular. Y la pregunta es: ¿qué debería revelarse para proporcionar esta pista? Esto nos lleva a la verdadera cuestión: ¿qué medir?

A pesar de la ingente cantidad de investigaciones que se han realizado, la situación de no poder localizar rastros de memoria sugiere la necesidad de incorporar nuevos métodos de investigación.

6. Importancia de la medición cerebral

Hemos hablado de la posibilidad de que el cerebro, que no es más que un recipiente, contribuya como fuente de valor, pero la elucidación del cerebro aún no ha llegado al punto en que pueda vincularse al valor. Comprender el cerebro requiere diversos conocimientos. El proceso de crecimiento del cerebro, los mecanismos de la memoria y la transducción de señales, y los modelos del cerebro basados en estos mecanismos son algunos ejemplos. La presencia o ausencia de conexiones con otros órganos también es importante. Los principios del comportamiento humano se han estudiado en psicología, pero en última instancia, una comprensión integrada del cerebro hasta sus funciones microscópicas permitirá debates que lo relacionen con el valor[36].Lo importante es cómo se vinculan el significado y el valor con la memoria y el procesamiento de señales en la transferencia de información neuronal. La cuestión es cómo se representan los conceptos abstractos de significado y valor en el nivel de las señales. Por ejemplo, la aparición de diferentes respuestas en un proceso repetitivo constante puede indicar algún significado. O puede ser importante que la respuesta cambie con patrones de entrada específicos.

Consideremos el caso en el que las señales externas a los cinco sentidos son siempre las mismas. Por ejemplo, si una persona está confinada en una habitación sin ventanas ni objetos, sólo con paredes, y tiene los ojos cerrados, puede pensar y crear. Un adulto que ya ha formado muchos recuerdos puede pensar y crear algo incluso sin señales del exterior. Si el significado y el valor sólo pueden crearse dentro del cerebro, el contenido de la señal de salida cambiaría espontáneamente, incluso si las señales externas son constantes.

La misma entrada, en una serie temporal, debería mostrar respuestas diferentes. Puede deberse a la reconexión o modificación de las neuronas, o a la reproducibilidad de la señal. Cómo se almacenan los recuerdos y se forman los valores será una clave importante para vincular el cerebro y la sociedad.

La psicología ha examinado muchos principios del comportamiento humano. Nosotros hemos examinado las características de la caja negra llamada cerebro basándonos en diversos estudios de casos. En el futuro, se logrará una mejor comprensión trazando un mapa de los acontecimientos psicológicos con pruebas más físicas basadas en el cerebro. Por ejemplo, los experimentos con ratones modificados genéticamente con cerebros alterados han revelado la relación entre la función cerebral y genes específicos [37]. Además, vincular el valor al cerebro revelaría cómo se consideran deseables determinados recuerdos y cómo se relacionan con el comportamiento.

La tecnología de medición ha progresado rápidamente y se han propuesto muchos modelos cerebrales, pero aún no han alcanzado un nivel que contribuya al esclarecimiento del cerebro. Por ejemplo, la velocidad y la resolución de las mediciones se consideran insuficientes. El modelo de cerebro sigue en proceso de debate sobre el principio de si es cuántico o no.

Se han medido estructuras microscópicas de regiones cerebrales, como el cerebro, el cerebelo, el lóbulo frontal, el lóbulo temporal y otros segmentos, y cada vez está más claro el papel general de cada región. La medición mediante electrodos como terminales de medida y fluorescencia como marcador de zonas específicas ha revelado las funciones de las neuronas, la unidad básica del cerebro, a nivel molecular.

Así pues, se han dedicado muchos esfuerzos al estudio del cerebro. Sin embargo, entre los diversos aspectos del conocimiento, los mecanismos del cerebro parecen ser los menos comprendidos. La memoria óptica Blu-ray almacena un único bit como unidad. En cada punto, un 1 o un 0 viene determinado por la alta o baja reflectancia. Ni siquiera sabemos cuáles son los trazos de memoria correspondientes en el cerebro. En otras palabras, el principio de la memoria no se entiende claramente. Por ejemplo, cuando memorizamos la cara de nuestra abuela, un ordenador la descompone en 1s y 0s y los almacena en circuitos IC, pero se desconoce qué tipo de información se almacena en el cerebro. Las imágenes por resonancia magnética (IRM) han proporcionado una gran cantidad de información. Además, es necesario mejorar las técnicas de medición en muchos aspectos, como la resolución espacial y temporal y la sensibilidad, la profundidad de penetración, la diferenciación elemental y la detección de cambios en la estructura molecular. En particular, nos centramos en las neuronas, la unidad básica del cerebro. Los puntos de interés son las ramificaciones de las señales hacia las neuronas vecinas y la modulación de la intensidad de cada señal en un corto periodo de tiempo. Si esto se puede medir con alta velocidad, alta sensibilidad, alta precisión, de forma no destructiva y sin contacto, es muy probable que se pueda obtener nueva información.

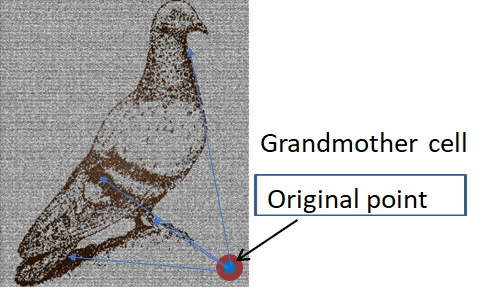

Fig.4 Imagen de una neurona de célula abuela y una paloma [16]

Fig.4 Imagen de una neurona de célula abuela y una paloma [16]Se dice que las huellas de memoria son ligeros cambios en la forma de las neuronas [38]. Pero, ¿puede una sola célula memorizar caras tan complejas?

Existe un concepto llamado holograma. En la memoria de hologramas, la información se graba en una superficie y, cambiando el ángulo de incidencia, por ejemplo, se pueden leer varias piezas de información. En la luz, la interferencia se basa en que se mantiene el frente de onda. Si las señales cerebrales se mantienen en la vaina de mielina, con su coherencia, no es sorprendente que se produzcan efectos de interferencia similares. La visión, donde la información de entrada es clara, sería la más fácil de analizar. La vía visual ha sido bien estudiada, pero no está claro cómo se relaciona con la memoria [39].

El holograma está deslocalizado con una zona de memoria ampliada, pero también existe un modelo de memoria localizada. Cuando un frente de onda es dispersado por una imagen y un punto de dispersión fuerte que sirve de referencia, la imagen original puede recuperarse mediante la transformación de Fourier del patrón de dispersión.

En esta medida de la dispersión de la luz, el contraste del patrón de dispersión es mayor cuando el punto focal está justo delante del dispersor. Si hay dos dispersores, el patrón viene determinado por la distancia entre ambos. Utilizando la distancia entre los dispersores como información, puede construirse un modelo de memoria. Si este modelo puede aplicarse a la memoria neuronal, podemos pensar en la célula abuela como el pilar central con la mayor intensidad de dispersión entre los múltiples dispersores, y el contraste será mayor cuando una onda de señales eléctricas en fase con la célula abuela llegue a la región que contiene la célula abuela y la célula correspondiente a su información.

Es decir, la información se forma a partir de la distancia entre esa célula y otras células, partiendo de esa célula. Si éste es el caso, sólo se están observando las señales fuertes, y la verdadera información estaría contenida en las señales débiles que fluyen hacia otras células.

La necesidad de medir las señales débiles podría deducirse de las células abuela. Si las señales débiles afectan a la memoria, es necesario medir la señal de cada neurona con alta sensibilidad. Dado que las señales son series de picos que se alinean a intervalos del orden de ms, es importante conseguir tanto alta velocidad como alta resolución. Cámaras recientes de alta sensibilidad y alta velocidad han logrado velocidades de medición de casi 1 μs por fotograma con alta sensibilidad y rango dinámico[40].

Nota: Por ejemplo, la cámara de alta velocidad FASTCAM Mini AX de Photron es una cámara de alta velocidad con una velocidad de disparo de 20.000 fotogramas por segundo a 640 x 480 píxeles. Además de la alta resolución de las imágenes monocromas de 12 bits, la cámara ha alcanzado una sensibilidad ultra alta de ISO monocromo 40.000.

El cerebro es una red neuronal de neuronas dispuestas en forma de celosía. La mayoría de los estudios anteriores se han limitado a la transmisión monosináptica en el mejor de los casos [41]. En realidad, ni siquiera la transmisión monosináptica se ha analizado con precisión. El método dominante para analizar la transmisión monosináptica ha sido insertar un electrodo en una neurona y medir el cambio de potencial. Sin embargo, en este método, el electrodo puede afectar a la señal. La medición óptica es un método prometedor para la medición sin contacto. Se está investigando un método de alta velocidad y alta resolución para la medición 3D por holografía o por absorción de dos fotones[42].

Además de la holografía y la absorción de dos fotones, existen otros métodos para medir ópticamente señales de múltiples neuronas que utilizan la dispersometría [43].

Los hologramas son superiores en el sentido de que permiten un fácil control de la captación espacial de la luz y de la posición de detección. La absorción de dos fotones es única en el sentido de que puede medir en las profundidades del cerebro. Por otro lado, la dispersometría es superior en términos de resolución y velocidad de medición.

El método de medición de las señales en el cerebro depende del objeto a medir. El cerebro puede dividirse en tres categorías: la superficie superior, unos milímetros de profundidad y todo el cerebro. Además, la resolución y la velocidad de medición son factores importantes. Los métodos de medición pueden clasificarse como sin contacto, con contacto o destructivos.

Las técnicas que pueden medir todo el cerebro son la tomografía computarizada por rayos X y la resonancia magnética. Estas técnicas pueden medir la estructura de todo el cerebro de forma no invasiva. La IRM, en particular, puede captar no sólo la estructura, sino también la motilidad molecular. Su resolución en el plano puede ser de 14 μm. Además, se puede determinar el diámetro de los haces nerviosos en zonas específicas del cerebro, como el cuerpo calloso, así como su orientación. Por ejemplo, se puede distinguir entre los que están a 2-4 µm y los que están a 10 µm [44].

En el caso de las superficies cerebrales, por ejemplo, el microscopio de fuerza atómica (AFM) y el microscopio de barrido de conducción iónica (SICM) pueden medir la forma tridimensional de una célula trazando su superficie con una sonda con precisión nanométrica [45]. El SICM utiliza el cambio en la corriente de iones causado por el cambio en la distancia entre la neurona y la sonda para obtener imágenes de la forma y la carga de la superficie sin tocar la muestra [46]. La velocidad de medición es lenta, alrededor de 25 μm^2/min, pero la resolución en la medición no destructiva es la más alta en comparación con otros métodos [47].

El método de medición de potenciales neuronales con electrodos es el que más resultados ha obtenido para la transmisión de información cerebral, aunque se trata de un método de contacto. Uno de estos métodos, el de patch-clamp, registra el comportamiento de los iones a través de canales y transportadores iónicos. Los transportadores de neurotransmisores terminan su neurotransmisión mediante la recaptación de los neurotransmisores liberados por las terminaciones nerviosas [48].

Un punto importante para evaluar la función del cerebro como instrumento basado en valores sería cómo se almacenan los recuerdos. Como resultado de la interacción con el mundo exterior, las decisiones basadas en la memoria determinarán el comportamiento de una persona.

Hasta ahora se han utilizado técnicas basadas en electrodos. Esto se debe a que es posible medir el interior del cerebro y medir la actividad de neuronas específicas. Aunque es un método prometedor, aún no ha sido capaz de captar las huellas de la memoria en el cerebro. Una de las razones puede ser que la propia medición afecta a los nervios porque es un método de contacto. No es adecuado para captar las diminutas señales eléctricas de los nervios.

El método típico para medir sin contacto esta señal eléctrica es la medición óptica.

9.1 Medición óptica de microestructuras

Es un deseo común de muchas personas ver con precisión la forma y el color de diminutas muestras con un microscopio óptico. En realidad, sólo hay un número limitado de casos en los que se puede cumplir este deseo, ya que el tamaño y el índice de refracción tienen un efecto complejo sobre la visibilidad. Los recientes avances en las técnicas de cálculo de la propagación de la luz están proporcionando pistas para resolver este problema.Ejemplos bien conocidos de cómo la forma y el tamaño influyen en el color son el arco iris de las pompas de jabón y las alas de las mariposas morfo. Normalmente, el color está muy influido por la parte imaginaria del índice de refracción complejo. Sin embargo, algunas estructuras pueden producir colores muy diferentes de los que se suponen a partir del índice de refracción complejo.

Por otra parte, la forma y el tamaño se perciben de forma diferente en función del índice de refracción complejo. Es bien sabido que la información sobre el índice de refracción es esencial en la medición del espesor de la película. Conocer la forma y el índice de refracción complejo de un microobjeto desconocido no es más que estimar estos parámetros a partir de la información medida sobre la forma, el tamaño y el color.

El color se ve afectado por la estructura en una región de tamaño de longitud de onda en la que se dice que el tamaño es el dominio de resonancia. Si la muestra es una partícula, el tamaño de la partícula en el dominio de resonancia es aproximadamente de 1 a 10 veces la longitud de onda. En la aproximación lineal, la luz se curva o viaja en línea recta en la superficie de la muestra y se mantiene el flujo luminoso. Sin embargo, en el caso de estas partículas, el flujo luminoso se propaga en la interfaz, y esta dispersión varía con la longitud de onda. Por lo tanto, los patrones de reflectancia y dispersión son diferentes a distintas longitudes de onda [49, 50, 51].

9.2 Clasificación de la medición óptica y la dispersometría

El principio de utilizar la luz para ver objetos pequeños (el principio de la microscopía) puede dividirse matemáticamente en tres grandes categorías basadas en el grado de aproximación. Una es el método de trazado de rayos que utiliza el hecho de que la luz viaja en línea recta. Se trata de una aproximación lineal. La luz viaja en línea recta a través de la muestra y la imagen de la muestra se proyecta tal cual. En la tomografía computarizada por rayos X, muy utilizada en medicina, la imagen tridimensional original se reconstruye a partir de esta imagen proyectada. El otro método consiste en utilizar imágenes ópticas. El principio de la óptica se basa en la acción de la transformada de Fourier de la lente [52,53]. Y la transformada de Fourier sólo es posible cuando se utiliza la aproximación de Fraunhofer o una aproximación similar, la aproximación de Born de primer orden. La aproximación de Fraunhofer es válida cuando la medición se realiza lo suficientemente lejos en comparación con el tamaño de la muestra [54]. Por lo tanto, no puede tener en cuenta las reflexiones múltiples y la dispersión múltiple dentro de la muestra, lo que requiere considerar la propagación de la luz a distancias cortas. La holografía, uno de los principales métodos para medir formas tridimensionales, se basa en la misma aproximación y considera que la luz reflejada en la superficie de la muestra es libre de propagarse. El tercero es un método que estima la imagen a partir del patrón de dispersión, teniendo estrictamente en cuenta el grosor y el índice de refracción de la muestra. Se denomina dispersometría. El proceso de obtención de la imagen original es de ensayo y error, y resulta difícil de aplicar a menos que la geometría sea sencilla. Sin embargo, si el análisis se realiza con éxito, el tamaño del objeto a medir puede reducirse en dos órdenes de magnitud en comparación con los otros dos principios, y la precisión puede mejorarse en dos órdenes de magnitud.La dispersometría es un método eficaz para la medición 3D de alta resolución y alta velocidad. Los principales métodos convencionales de medición 3D de alta resolución son la imagen de lente, la holografía y la reproducción de fase. Los métodos de holografía y reproducción de fase son adecuados para obtener imágenes 3D a alta velocidad, pero suponen el uso de la transformada de Fourier, que hace la suposición de la aproximación de Fraunhofer. Por lo tanto, cuando la dispersión y la absorción son grandes, estos métodos están limitados a unas 100 longitudes de onda, incluso cuando el tamaño del objetivo de medición es pequeño, y la precisión es sólo de unas 10 longitudes de onda [55]. La dispersometría es una evaluación numérica rigurosa de las ecuaciones de Maxwell, que son los principios de la óptica . El rendimiento es similar cuando la absorción y la dispersión son grandes. Por lo tanto, mejora la precisión en dos órdenes de magnitud en la medición de la forma 3D cuando la dispersión y la absorción son grandes en comparación con el análisis mediante la transformada de Fourier [56].

Otra ventaja de la dispersometría es su alta velocidad de medición. La dispersometría es capaz de realizar mediciones 3D de alta resolución en un solo disparo en un rango de varias a varias decenas de longitudes de onda. Es más rápida que las mediciones de superresolución, que se basan en el tiempo de decaimiento de la fluorescencia, o que las mediciones de absorción de dos fotones, que se basan en mediciones de un solo punto.

La dispersometría es especialmente útil para la luz visible y ultravioleta y para los rayos ultravioleta muy cortos y los rayos X suaves, en los que las diferencias de índice de refracción y coeficiente de extinción entre el medio y la muestra suelen ser grandes y susceptibles de dispersión. A tamaños de muestra de unas 10 longitudes de onda, la aproximación de Fraunhofer, principio básico de la imagen de lente y la holografía, no es válida. Cuando la muestra es delgada, los efectos de difracción y dispersión son pequeños y pueden analizarse con esta aproximación, pero cuando la muestra es más gruesa, se hace más difícil [57].

La desventaja de la dispersometría es que es difícil de analizar y la imagen original no se determina de forma única. Por otro lado, las aproximaciones lineal y Fraunhofer proporcionan una correspondencia uno a uno entre la imagen original y el patrón de dispersión. Las soluciones matemáticas se obtienen de forma fiable y su velocidad es rápida.

En dispersometría, encontrar la imagen original a partir del patrón de dispersión se denomina resolver un problema inverso. Para resolver problemas inversos se utilizan métodos de aprendizaje profundo o de mínimos cuadrados. Actualmente, se limitan a formas simples que son columnares y tienen una sección transversal rectangular, triangular o elíptica de la columna.

La dispersometría es muy útil cuando la longitud de onda es limitada, como en las mediciones en el visible y el ultravioleta, o cuando la destrucción de la muestra a longitudes de onda cortas es un problema, como en la medición de materiales orgánicos con rayos X. Con la dispersión, la longitud de onda puede multiplicarse por 100 para obtener la misma resolución. Teniendo en cuenta este efecto, la resolución mejora en un factor superior a 10 si el daño de la muestra se mantiene al mismo nivel.

La medición óptica es no destructiva, sin contacto y rápida. En general, cuanto mayor es la energía (longitud de onda más corta), mayor es la resolución, incluidos los haces de electrones. Por otro lado, cuanto mayor es la energía, más probable es que la muestra sea destruida por la luz medida [58]. Esto es especialmente problemático en el caso de materiales orgánicos como los organismos vivos.

Como resultado de esta compensación, el límite en el que se puede alcanzar tanto la resolución como la destrucción de la muestra se ha situado convencionalmente en torno a los 10 nm de longitud de onda.

9.3 Difracción coherente y sus limitaciones

La dispersión de luz procedente de láseres puede considerarse como luz perfectamente coherente y puede describirse matemáticamente de forma concisa. Por otro lado, la luz blanca, como la de las lámparas halógenas, requiere un tratamiento que tenga en cuenta el grado de incoherencia, dependiendo del tamaño de la muestra y de la longitud de onda. La razón por la que la luz coherente es adecuada para medir el tamaño de los objetos es que las propiedades de la luz parcialmente coherente son indeterminadas en el grado de incoherencia, y los cálculos se complican en función del grado de incoherencia.En principio, la dispersión de luz coherente puede predecir con exactitud el patrón de dispersión mediante métodos de cálculo óptico. Aunque las propiedades de las micromuestras varían mucho en cuanto a las partes real e imaginaria del índice de refracción, la forma, la longitud vertical, la longitud horizontal, etc., se puede medir una gran cantidad de datos experimentales cambiando el ángulo de incidencia y la longitud de onda, y midiendo la distribución del ángulo de dispersión de la transmisión y la reflexión, así como la reflectancia y la transmitancia, de modo que se puede obtener información aproximada.

Cuando se mide realmente la muestra, nos encontramos con el problema de que la luz coherente se vuelve incoherente dentro de la muestra. Este problema se produce incluso cuando los dispersores en el interior son pequeños y tienen poco efecto en el patrón de dispersión. Los cálculos exactos de la dispersión de la luz suponen que la luz es coherente, lo que conduce a grandes errores.

Si se conociera con exactitud la distribución del índice de refracción interno de una muestra desconocida, podría calcularse, pero la intensidad de dispersión de los microdispersores es pequeña y su número es innumerable, lo que dificulta la medición de la distribución. En este caso, la coherencia puede utilizarse como indicador. Se supone que la coherencia disminuye uniformemente dentro de la muestra. Se trata de una gran aproximación, pero la concordancia con el experimento es mejor que si no se tiene en cuenta nada en absoluto [59].

La dispersometría tiene la ventaja de no hacer ninguna aproximación, pero en cambio tiene la desventaja de que la forma original no se puede obtener directamente a partir del patrón de dispersión utilizando una transformada inversa de Fourier o similar. Esta técnica sólo puede utilizarse cuando la forma original es sencilla o cuando se conoce la forma aproximada. Este método es adecuado para el análisis cuando se conoce la forma aproximada y sólo se necesita una forma transversal, como en el caso de las neuronas.

9.4 Medición óptica tridimensional de alta velocidad y resolución de los nervios

El principio de utilizar la luz para ver objetos pequeños (el principio de la microscopía) puede dividirse, como ya se ha mencionado, en 1. aproximación lineal, 2. aproximación Fraunhofer y 3. método de solución exacta (dispersometría). El segundo método se utiliza a menudo junto con la fluorescencia en la medición de las señales nerviosas. La emisión de un fluoróforo ha dado lugar a una mejora significativa de la resolución espacial al capturar sólo la emisión de una única molécula de forma resuelta en el tiempo: microscopía de reconstrucción óptica estocástica (STORM). Este método no podía mejorar la resolución temporal a menos que la frecuencia de luminiscencia fuera alta, y la intensidad de la luz de excitación, o la intensidad de enfoque que podía soportar la muestra, limitaban tanto la velocidad como la resolución de la medición.El tercero, la dispersometría, no sólo no requiere etiquetado fluorescente, sino que también tiene el potencial de mejorar significativamente la resolución temporal.

9.5 Dispositivo de medición óptica versátil por dispersometría (microscopio de alta precisión)

La muestra real es a menudo muy diferente de la imagen que puede representarse mediante la aproximación de Fraunhofer. En la luz visible y en los rayos X blandos, donde los efectos de la absorción y la dispersión son significativos, esta discrepancia es notable debido a una mayor absorción y a la dispersión múltiple dentro de la muestra. En tales casos, la dispersometría puede mejorar la resolución en unos dos órdenes de magnitud para mediciones 3D de geometrías sencillas en comparación con la obtención de imágenes mediante lentes. Además, es posible medir con una resolución temporal inferior a un milisegundo. Se trata de un método de medición no destructivo, sin contacto y sencillo. Es posible la detección rápida y de alta resolución de cambios en la distribución del índice de refracción relacionados con la transducción de señales neuronales [60,61]. Los recientes avances en las técnicas de cálculo óptico descritas anteriormente han permitido analizar cuantitativamente la forma y el tamaño.La distribución del índice de refracción puede revelarse si puede calcularse con precisión la relación entre la distribución del índice de refracción en la sección transversal y el patrón de dispersión en el campo lejano. Como método para calcular la distribución angular de la luz dispersada, utilizaremos el Análisis Riguroso de Ondas Acopladas (RCWA). La razón de ello es que la estructura interna puede tenerse en cuenta fácilmente y el patrón de dispersión del campo lejano puede calcularse directamente. Aunque el RCWA sólo se ocupa de estructuras periódicas, también puede aplicarse a sistemas aislados ideando el método de cálculo [62]. Además, la selección de una estructura específica requiere enfocar la luz en el lugar de medida, y el ajuste de la relación posicional entre el punto de enfoque y la muestra tiene un impacto significativo en la reproducibilidad, pero el contraste del patrón de dispersión puede ajustarse para asegurar la reproducibilidad [63].

La combinación del segundo y el tercer método permite obtener imágenes en tiempo real y mediciones de alta resolución. Existen ejemplos de dispersometría de luz visible de patrones de difracción de neuronas en muestras de cerebro de gatos teñidas con Golgi y muestras de cerebelo de humanos teñidas con Weigert [43].

9.6 Uso de la no linealidad óptica y medición de la diferencia de tiempo

Cada vez se utilizan más las mediciones que aprovechan las no linealidades en la absorción y dispersión ópticas, en la absorción de dos fotones y en la dispersión Raman. Estas técnicas pueden aumentar la resolución espacial en comparación con las mediciones que no utilizan la no linealidad.El límite de difracción define la resolución, y estos son métodos para obtener resolución más allá de este límite de difracción. La formación de imágenes de estos métodos se ha estudiado en el marco de la óptica de Fourier. Sin embargo, la resolución puede aumentarse para cada punto de medición utilizando la no linealidad. Por ejemplo, el proceso de absorción de dos fotones por un fósforo se limita a las zonas donde la intensidad luminosa es fuerte. De este modo, es posible medir sólo un área más estrecha que el área de enfoque de luz de una lente para la absorción monofotónica. En la absorción de dos fotones, la longitud de onda de la luz incidente es el doble de la longitud de onda de medición. Esto permite seleccionar una longitud de onda con baja absorción y dispersión en organismos vivos y medir en profundidad en la muestra [64]. El problema es que la adquisición de formas tridimensionales requiere la adquisición de un gran número de puntos, lo que suele dar lugar a una resolución temporal deficiente.

Otra técnica es la dispersión Raman no lineal [65]. El Raman no lineal es superior al Raman lineal tanto en resolución temporal como espacial y, seleccionando la longitud de onda, es posible medir en profundidad en el tejido celular. [66, 67]. La constante dieléctrica varía con la intensidad del campo eléctrico. Si podemos observar sólo donde este cambio de intensidad es grande, podemos ser capaces de observar una porción de la luz incidente que es más pequeña que el diámetro focal de la luz incidente [65]. La dispersión Raman tiene generalmente una baja sensibilidad y requiere un largo tiempo de medida. Para resolver este problema, se ha desarrollado un método para amplificar la intensidad de la señal haciendo resonar la diferencia de energía entre dos longitudes de onda de la luz incidente y el modo vibracional Raman de la molécula de la muestra.

El otro método consiste en utilizar la resolución temporal, como en STORM. La emisión de fluorescencia de fotón único tiene una dispersión limitada por difracción que define la resolución del objetivo. Sin embargo, si se puede evaluar con precisión su centro, se puede conseguir una resolución sustancialmente mayor.

El problema de los métodos que utilizan medidas de no linealidad y diferencia temporal es que resulta difícil aumentar la resolución temporal. Cuanto mayor sea la intensidad del láser, mejor será la resolución temporal, pero más frágil será la muestra.

Referencia

Historial de revisiones

- 2023.9.9 Versión 1 2

- 2023.7.19 Obtención del certificado SSL 1a